文档

Kafka 3.5 文档

早期版本: 0.7.x, 0.8.0, 0.8.1.X, 0.8.2.X, 0.9.0.X, 0.10.0.X, 0.10.1.X, 0.10.2.X, 0.11.0.X, 1.0.X, 1.1.X, 2.0.X, 2.1.X, 2.2.X, 2.3.X, 2.4.X, 2.5.X, 2.6.X, 2.7.X, 2.8.X, 3.0.X, 3.1.X, 3.2.X,3.3.X、3.4.X1. 开始使用

1.1 介绍

什么是事件流式处理?

事件流是人体中枢神经系统的数字等价物。它是 为“永远在线”的世界奠定技术基础,在这个世界里,企业越来越多地使用软件定义 和 automated,而软件的用户更多的是 Software。

从技术上讲,事件流式处理是从事件源实时捕获数据的做法 如数据库、传感器、移动设备、云服务和流形式的软件应用程序 事件;持久存储这些事件流以供以后检索;作、处理和反应 实时和回顾性地访问事件流;并将事件流路由到不同的 destination 技术。因此,事件流确保了 数据,以便在正确的时间、正确的地点提供正确的信息。

事件流式处理可以用于什么?

事件流适用于众多行业和组织的各种使用案例。它的许多示例包括:

- 实时处理付款和金融交易,例如在证券交易所、银行和保险中。

- 实时跟踪和监控汽车、卡车、车队和货物,例如物流和汽车行业。

- 持续捕获和分析来自 IoT 设备或其他设备(例如工厂和风电场)的传感器数据。

- 收集客户互动和订单并立即做出反应,例如在零售、酒店和旅游行业以及移动应用程序中。

- 监测住院护理的患者并预测病情变化,以确保在紧急情况下得到及时治疗。

- 连接、存储和提供公司不同部门生成的数据。

- 作为数据平台、事件驱动型架构和微服务的基础。

Apache Kafka® 是一个事件流式处理平台。那是什么意思?

Kafka 结合了三个关键功能,因此您可以使用单个久经考验的解决方案实现端到端事件流的使用案例:

- 发布(写入)和订阅(读取)事件流,包括连续导入/导出 来自其他系统的数据。

- 根据需要持久可靠地存储事件流。

- 在事件发生时或回顾性地处理事件流。

所有这些功能都以分布式、高度可扩展、弹性、容错和 安全的方式。Kafka 可以部署在裸机硬件、虚拟机和容器上,也可以部署在本地 以及在云中。您可以选择自行管理 Kafka 环境和使用完全托管式 由各种供应商提供的服务。

简而言之,Kafka 是如何工作的?

Kafka 是一个分布式系统,由服务器和客户端组成,这些服务器和客户端 通过高性能 TCP 网络协议进行通信。 它可以部署在本地和云中的裸机硬件、虚拟机和容器上 环境。

服务器:Kafka 作为一个或多个服务器的集群运行,这些服务器可以跨越多个数据中心 或云区域。其中一些服务器构成了存储层,称为代理。其他服务器运行 Kafka Connect 以持续导入和导出 数据作为事件流,以将 Kafka 与现有系统(如关系数据库)集成,以及 其他 Kafka 集群。为了让您实施任务关键型使用案例,Kafka 集群具有高度可扩展性 和容错:如果它的任何服务器出现故障,其他服务器将接管它们的工作以确保 连续运行,不会丢失任何数据。

客户端:它们允许您编写分布式应用程序和微服务,这些应用程序以及读取、写入、 并行、大规模和以容错方式处理事件流,即使在网络的情况下也是如此 问题或机器故障。Kafka 附带了一些这样的客户端,这些客户端由 Kafka 提供的数十个客户端进行增强 社区:客户端可用于 Java 和 Scala,包括更高级别的 Kafka Streams 库、Go、Python、C/C++ 和 许多其他编程语言以及 REST API。

主要概念和术语

事件记录了世界上或您的企业中 “发生了什么” 的事实。在文档中也称为 record 或 message。当您向 Kafka 读取或写入数据时,您以事件的形式执行此作。从概念上讲,事件具有键、值、时间戳和可选的元数据标头。下面是一个示例事件:

- 事件键:“Alice”

- 事件价值:“已向 Bob 支付 200 美元”

- 事件时间戳:“2020 年 6 月 25 日下午 2:06。

创建者是将事件发布(写入)到 Kafka 的客户端应用程序,而使用者是订阅(读取和处理)这些事件的客户端应用程序。在 Kafka 中,生产者和使用者完全解耦且彼此不可知,这是实现 Kafka 众所周知的高可扩展性的关键设计元素。例如,生产者永远不需要等待消费者。Kafka 提供各种保证,例如能够精确处理一次事件。

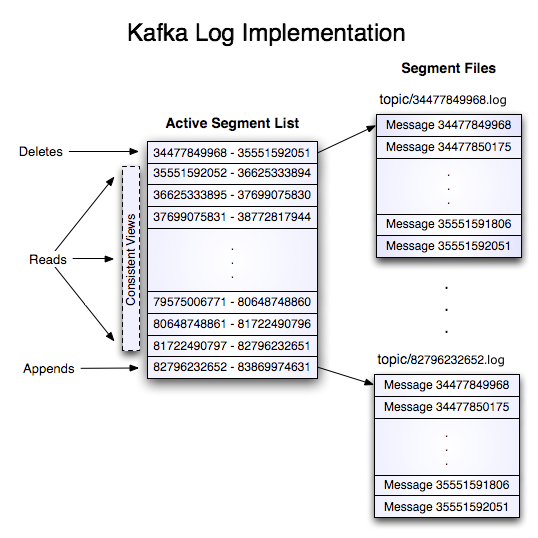

事件被组织并持久存储在主题中。非常简单,主题类似于文件系统中的文件夹,事件是该文件夹中的文件。示例主题名称可以是 “payments”。Kafka 中的主题始终是多创建者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的创建者,以及订阅这些事件的零个、一个或多个使用者。可以根据需要随时读取主题中的事件 - 与传统消息传递系统不同,事件在使用后不会删除。相反,您可以通过每个主题的配置设置定义 Kafka 应将事件保留多长时间,之后将丢弃旧事件。Kafka 的性能在数据大小方面实际上是恒定的,因此长时间存储数据是完全可以的。

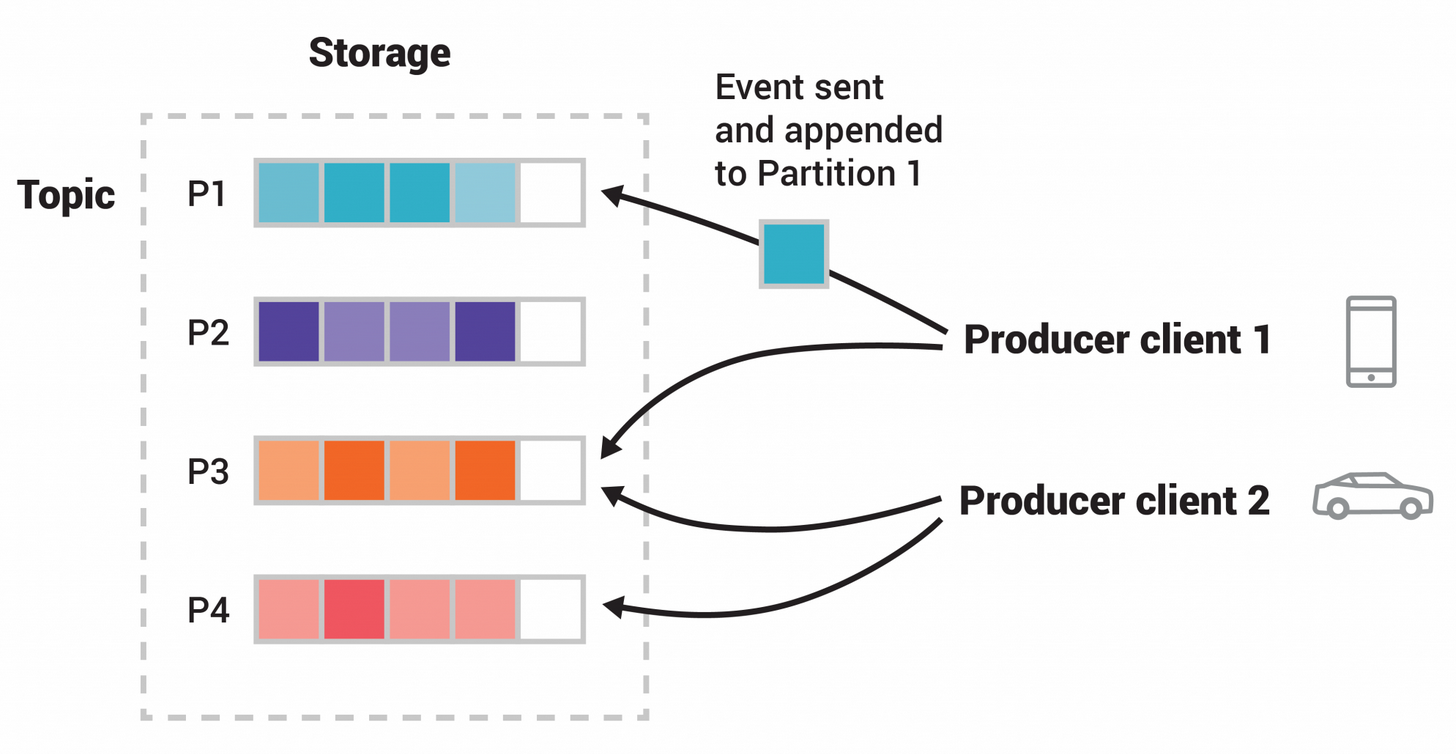

主题是分区的,这意味着主题分布在位于不同 Kafka 代理上的多个“存储桶”中。这种分布式数据放置对于可伸缩性非常重要,因为它允许客户端应用程序同时从多个代理读取和写入数据。当新事件发布到主题时,它实际上会附加到主题的某个分区中。具有相同事件键的事件(例如,客户或车辆 ID)将写入同一分区,Kafka 保证给定主题分区的任何使用者将始终以与写入事件完全相同的顺序读取该分区的事件。

为了使您的数据具有容错性和高可用性,每个主题都可以复制,甚至可以跨地理区域或数据中心复制,以便始终有多个代理拥有数据副本,以防万一出现问题,您想对代理进行维护,等等。常见的生产设置是复制因子 3,即数据始终有三个副本。此复制在 topic-partitions 级别执行。

这本引物应该足以作为介绍。如果您感兴趣,文档的 Design 部分详细介绍了 Kafka 的各种概念。

Kafka API 接口

除了用于管理和管理任务的命令行工具外,Kafka 还具有适用于 Java 和 Scala 的五个核心 API:

- 用于管理和检查主题、代理和其他 Kafka 对象的 Admin API。

- 生产者 API,用于将事件流发布(写入)到一个或多个 Kafka 主题。

- Consumer API,用于订阅(读取)一个或多个主题并处理向它们生成的事件流。

- Kafka Streams API,用于实施流处理应用程序和微服务。它提供更高级别的函数来处理事件流,包括转换、聚合和联接等有状态作、窗口化、基于事件时间的处理等。从一个或多个主题中读取输入,以便生成对一个或多个主题的输出,从而有效地将输入流转换为输出流。

- Kafka Connect API,用于构建和运行可重用的数据导入/导出连接器,这些连接器使用(读取)或生成(写入)来自外部系统和应用程序的事件流,以便它们可以与 Kafka 集成。例如,指向关系数据库(如 PostgreSQL)的连接器可能会捕获对一组表的每次更改。但是,在实践中,您通常不需要实施自己的连接器,因为 Kafka 社区已经提供了数百个现成的连接器。

从这里去哪里

- 要获得 Kafka 的实践经验,请遵循快速入门。

- 要更详细地了解 Kafka,请阅读文档。 您还可以选择 Kafka 书籍和学术论文。

- 浏览用例,了解我们全球社区中的其他用户如何从 Kafka 中获得价值。

- 加入当地的 Kafka 聚会小组,观看 Kafka 社区的主要会议 Kafka 峰会的演讲。

1.2 使用案例

以下是 Apache Kafka® 的一些常见使用案例的描述。 有关其中许多领域的实际应用概述,请参阅此博客文章。

消息

Kafka 可以很好地替代更传统的消息代理。 使用消息代理的原因有很多(将处理与数据创建者分离、缓冲未处理的消息等)。 与大多数消息传递系统相比,Kafka 具有更好的吞吐量、内置分区、复制和容错功能,这使其成为一个很好的 适用于大规模消息处理应用程序的解决方案。根据我们的经验,消息传递用途通常吞吐量相对较低,但可能需要较低的端到端延迟,并且通常依赖于强大的 Kafka 提供的持久性保证。

在这个领域,Kafka 可与 ActiveMQ 或 RabbitMQ 等传统消息传递系统相媲美。

网站活动跟踪

Kafka 的原始用例是能够将用户活动跟踪管道重建为一组实时发布-订阅源。 这意味着网站活动(页面查看、搜索或用户可能执行的其他作)将发布到中心主题,每个活动类型一个主题。 这些订阅源可用于一系列使用案例,包括实时处理、实时监控和加载到 Hadoop 或 用于离线处理和报告的离线数据仓库系统。活动跟踪通常非常高,因为每个用户页面视图都会生成许多活动消息。

指标

Kafka 通常用于运营监控数据。 这涉及聚合来自分布式应用程序的统计数据,以生成运营数据的集中源。日志聚合

许多人使用 Kafka 作为日志聚合解决方案的替代品。 日志聚合通常从服务器收集物理日志文件,并将它们放在一个中心位置(可能是文件服务器或 HDFS)进行处理。 Kafka 抽象出文件的详细信息,并将日志或事件数据更清晰地抽象为消息流。 这允许更低的处理延迟,并更轻松地支持多个数据源和分布式数据使用。 与 Scribe 或 Flume 等以日志为中心的系统相比,Kafka 提供了同样好的性能、更强的持久性保证(由于复制)、 以及更低的端到端延迟。流处理

Kafka 的许多用户在由多个阶段组成的处理管道中处理数据,其中原始输入数据从 Kafka 主题中使用,然后 聚合、丰富或以其他方式转换为新主题以供进一步使用或后续处理。 例如,用于推荐新闻文章的处理管道可能会从 RSS 源中抓取文章内容并将其发布到“文章”主题; 进一步的处理可能会规范化或删除重复的内容,并将清理后的文章内容发布到新主题; 最终处理阶段可能会尝试向用户推荐此内容。 此类处理管道根据各个主题创建实时数据流图。 从 0.10.0.0 开始,Apache Kafka 中提供了一个名为 Kafka Streams 的轻量级但功能强大的流处理库,用于执行上述数据处理。 除了 Kafka Streams,其他开源流处理工具还包括 Apache Storm 和 Apache Samza。事件溯源

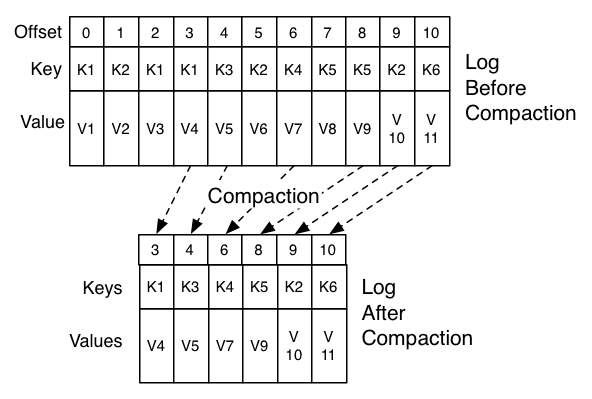

事件溯源是一种应用程序设计风格,其中状态更改被记录为 按时间排序的记录序列。Kafka 对非常大的存储日志数据的支持使其成为以这种样式构建的应用程序的出色后端。提交日志

Kafka 可以用作分布式系统的一种外部提交日志。日志有助于在节点之间复制数据并充当重新同步 失败节点恢复其数据的机制。 Kafka 中的日志压缩功能有助于支持这种用法。 在这个用法中,Kafka 类似于 Apache BookKeeper 项目。1.3 快速开始

第 2 步:启动 Kafka 环境

注意:您的本地环境必须安装 Java 8+。

Apache Kafka 可以使用 ZooKeeper 或 KRaft 启动。要开始使用任一配置,请遵循以下部分之一,但不能同时执行这两部分。

带有 ZooKeeper 的 Kafka

运行以下命令以按正确顺序启动所有服务:

# Start the ZooKeeper service

$ bin/zookeeper-server-start.sh config/zookeeper.properties打开另一个终端会话并运行:

# Start the Kafka broker service

$ bin/kafka-server-start.sh config/server.properties成功启动所有服务后,您将有一个基本的 Kafka 环境运行并可供使用。

带有 KRaft 的 Kafka

生成集群 UUID

$ KAFKA_CLUSTER_ID="$(bin/kafka-storage.sh random-uuid)"设置日志目录的格式

$ bin/kafka-storage.sh format -t $KAFKA_CLUSTER_ID -c config/kraft/server.properties启动 Kafka 服务器

$ bin/kafka-server-start.sh config/kraft/server.properties成功启动 Kafka 服务器后,您将有一个基本的 Kafka 环境运行并可供使用。

第 3 步:创建主题以存储您的事件

Kafka 是一个分布式事件流平台,可让您读取、写入、存储和处理事件(在文档中也称为记录或消息) 跨多台机器。

示例事件包括付款交易、手机的地理位置更新、发货订单、传感器测量 来自 IoT 设备或医疗设备等等。这些事件被组织并存储在主题中。 非常简单,主题类似于文件系统中的文件夹,事件是该文件夹中的文件。

因此,在编写第一个事件之前,必须创建一个主题。打开另一个终端会话并运行:

$ bin/kafka-topics.sh --create --topic quickstart-events --bootstrap-server localhost:9092所有 Kafka 的命令行工具都有额外的选项:运行kafka-topics.sh命令,没有任何

参数来显示使用信息。例如,它还可以显示新主题的分区计数等详细信息:

$ bin/kafka-topics.sh --describe --topic quickstart-events --bootstrap-server localhost:9092

Topic: quickstart-events TopicId: NPmZHyhbR9y00wMglMH2sg PartitionCount: 1 ReplicationFactor: 1 Configs:

Topic: quickstart-events Partition: 0 Leader: 0 Replicas: 0 Isr: 0步骤 4:将一些事件写入主题

Kafka 客户端通过网络与 Kafka 代理通信以写入(或读取)事件。 收到事件后,代理将以持久且容错的方式存储事件,只要您 需要——甚至永远。

运行控制台创建者客户端,将一些事件写入您的主题中。 默认情况下,您输入的每一行都会导致将单独的事件写入主题。

$ bin/kafka-console-producer.sh --topic quickstart-events --bootstrap-server localhost:9092

This is my first event

This is my second event您可以使用Ctrl-C随时。

步骤 5:读取事件

打开另一个终端会话并运行控制台使用者客户端以读取您刚刚创建的事件:

$ bin/kafka-console-consumer.sh --topic quickstart-events --from-beginning --bootstrap-server localhost:9092

This is my first event

This is my second event您可以使用Ctrl-C随时。

随意尝试:例如,切换回您的 producer 终端(上一步)以编写 additional events 的 Events,并查看事件如何立即显示在您的消费终端中。

由于事件持久存储在 Kafka 中,因此您可以根据需要多次读取这些事件,并由任意数量的使用者读取。 您可以通过打开另一个终端会话并再次重新运行上一个命令来轻松验证这一点。

第 6 步:使用 Kafka Connect 将数据导入/导出为事件流

您可能在现有系统(如关系数据库或传统消息传递系统)中拥有大量数据。 以及许多已经使用这些系统的应用程序。Kafka Connect 允许您持续摄取 数据从外部系统到 Kafka,反之亦然。它是一个运行连接器的可扩展工具,这些连接器实现用于与外部系统交互的自定义逻辑。 因此,将现有系统与 Kafka 集成非常容易。为了使此过程更加简单, 有数百个这样的连接器随时可用。

在本快速入门中,我们将了解如何使用导入数据的简单连接器运行 Kafka Connect 从文件导出到 Kafka 主题,并将数据从 Kafka 主题导出到文件。

首先,确保添加到connect-file-3.5.2.jarplugin.pathConnect worker 配置中的属性。

在本快速入门中,我们将使用相对路径,并将连接器的包视为一个 uber jar,当从安装目录运行快速入门命令时,该 jar 将起作用。

但是,值得注意的是,对于生产部署,使用绝对路径始终是可取的。有关如何设置此配置的详细说明,请参阅 plugin.path。

编辑文件,添加或更改config/connect-standalone.propertiesplugin.pathconfiguration 属性与以下内容匹配,然后保存文件:

> echo "plugin.path=libs/connect-file-3.5.2.jar"

然后,首先创建一些种子数据以进行测试:

> echo -e "foo\nbar" > test.txt或者在 Windows 上:

> echo foo> test.txt > echo bar>> test.txt

接下来,我们将启动两个以独立模式运行的连接器,这意味着它们在单个本地专用 过程。我们提供了三个配置文件作为参数。第一个始终是 Kafka Connect 的配置 进程,其中包含常见配置,例如要连接的 Kafka 代理和数据序列化格式。 其余配置文件分别指定要创建的连接器。这些文件包括一个唯一的连接器名称,即 类来实例化,以及连接器所需的任何其他配置。

> bin/connect-standalone.sh config/connect-standalone.properties config/connect-file-source.properties config/connect-file-sink.properties

这些示例配置文件(包含在 Kafka 中)使用您之前启动的默认本地集群配置 并创建两个连接器:第一个是源连接器,它从输入文件中读取行并将每个行生成到 Kafka 主题 第二个是接收器连接器,它从 Kafka 主题中读取消息,并在输出文件中将每个消息生成为一行。

在启动过程中,您将看到许多日志消息,其中一些消息指示连接器正在实例化。

Kafka Connect 进程启动后,源连接器应开始从test.txt和

针对主题制作它们connect-test,接收器连接器应开始从主题connect-test并将它们写入文件test.sink.txt.我们可以验证数据是否已通过整个管道交付

通过检查输出文件的内容:

> more test.sink.txt foo bar

请注意,数据存储在 Kafka 主题中connect-test,因此我们还可以运行控制台使用者来查看

data 中(或使用自定义使用者代码对其进行处理):

> bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic connect-test --from-beginning

{"schema":{"type":"string","optional":false},"payload":"foo"}

{"schema":{"type":"string","optional":false},"payload":"bar"}

...

连接器继续处理数据,因此我们可以将数据添加到文件中,并查看它在管道中移动:

> echo Another line>> test.txt

您应该会看到该行出现在控制台使用者输出和 sink 文件中。

第 7 步:使用 Kafka Streams 处理事件

将数据作为事件存储在 Kafka 中后,您可以使用适用于 Java/Scala 的 Kafka Streams 客户端库处理数据。 它允许您实施任务关键型实时应用程序和微服务,其中输入 和/或输出数据存储在 Kafka 主题中。Kafka Streams 结合了编写和部署的简单性 客户端的标准 Java 和 Scala 应用程序,具有 Kafka 服务器端集群的优势 技术使这些应用程序具有高度可扩展性、弹性、容错性和分布式。库 支持恰好一次处理、有状态作和聚合、窗口化、联接、基于处理 在事件时间等等。

为了让您初步体验一下,以下是如何实现流行的WordCount算法:

KStream<String, String> textLines = builder.stream("quickstart-events");

KTable<String, Long> wordCounts = textLines

.flatMapValues(line -> Arrays.asList(line.toLowerCase().split(" ")))

.groupBy((keyIgnored, word) -> word)

.count();

wordCounts.toStream().to("output-topic", Produced.with(Serdes.String(), Serdes.Long()));Kafka Streams 演示和应用程序开发教程演示了如何从头到尾编写和运行此类流式处理应用程序。

步骤 8:终止 Kafka 环境

现在,您已经完成了快速入门的结尾,请随时拆除 Kafka 环境,或者 继续玩。

- 停止生产者和使用者客户端

Ctrl-C,如果您尚未执行此作。 - 停止 Kafka 代理

Ctrl-C. - 最后,如果遵循 Kafka with ZooKeeper 部分,请使用

Ctrl-C.

如果您还想删除本地 Kafka 环境的任何数据,包括您创建的任何事件 在此过程中,运行以下命令:

$ rm -rf /tmp/kafka-logs /tmp/zookeeper /tmp/kraft-combined-logs祝贺!

您已成功完成 Apache Kafka 快速入门。

要了解更多信息,我们建议执行以下步骤:

- 通读简短的简介,了解 Kafka 在高层次上的工作原理、它的主要概念以及它与其他产品的比较 技术。要更详细地了解 Kafka,请前往 文档。

- 浏览使用案例以了解如何作 我们全球社区中的其他用户正在从 Kafka 中获得价值。

- 加入当地的 Kafka 聚会小组,观看 Kafka 峰会的演讲。 Kafka 社区的主要会议。

从任何版本 0.8.x 到 3.4.x 升级到 3.5.2

所有升级步骤与升级到 3.5.0 相同3.5.2 中的显著变化

- 当将生产者 ID 区块从 ZK 迁移到 KRaft 时,可能会有重复的生产者 ID 被赋予 事务性或幂等生产者。这可能会导致长期问题,因为生产者 ID 是 保留并重用了很长时间。 有关更多详细信息,请参阅 KAFKA-15552。

- 在 3.5.0 和 3.5.1 中,可能存在在 AlterPartition 请求后从控制器返回空 ISR 的问题 在滚动升级期间。此问题将影响 topic 分区的可用性。 有关更多详细信息,请参阅 KAFKA-15353。

从任何版本 0.8.x 到 3.4.x 升级到 3.5.1

所有升级步骤与升级到 3.5.0 相同3.5.1 中的显著变化

- 将依赖项 snappy-java 升级到不易受 CVE-2023-34455 攻击的版本。您可以在 Kafka CVE 列表中找到有关 CVE 的更多信息。

- 修复了 3.3.0 中引入的回归,该回归导致

security.protocol要限制为的配置值 仅限大写。修复后,security.protocol值不区分大小写。 有关详细信息,请参阅 KAFKA-15053。

从任何版本 0.8.x 到 3.4.x 升级到 3.5.0

3.5.0 中的显著更改

- Kafka Streams 引入了一种新的状态存储类型,即版本化的键值存储、 用于为每个键存储多个记录版本,从而启用时间戳检索 作返回截至指定时间戳的最新记录(每个键)。 有关更多详细信息,请参阅 KIP-889 和 KIP-914。 如果在 DSL 中使用新的存储类型化,则会应用 KIP-914 中所述的改进处理语义。

- KTable 聚合语义通过 KIP-904 得到了进一步改进, 现在避免虚假的中间结果。

- Kafka Streams 的

ProductionExceptionHandler通过 KIP-399 得到改进, 现在还涵盖序列化错误。 - MirrorMaker 现在默认使用 incrementalAlterConfigs API 来同步主题配置,而不是已弃用的 alterConfigs API。

一个名为

use.incremental.alter.configs允许用户控制要使用的 API。 此新设置被标记为已弃用,并且当始终使用 incrementalAlterConfigs API 时,将在下一个主要版本中删除该设置。 有关详细信息,请参阅 KIP-894。 - JmxTool、EndToEndLatency、StreamsResetter、ConsumerPerformance 和 ClusterTool 已迁移到 tools 模块。 “kafka.tools”包已弃用,在下一个主要版本中将更改为“org.apache.kafka.tools”。 有关更多详细信息,请参阅 KAFKA-14525。

升级基于 ZooKeeper 的集群

如果您从 2.1.x 之前的版本升级,请参阅下面步骤 5 中有关用于存储使用者偏移量的架构的更改的说明。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.4,3.3等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.4,3.3等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为3.5. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 更改为 3.5,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

升级基于 KRaft 的集群

如果您要从 3.3.0 之前的版本升级,请参阅下面第 3 步中的说明。将 metadata.version 更改为最新版本后,将无法降级到 3.3-IV0 之前的版本。

对于滚动升级:

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。

- 验证集群的行为和性能后,通过运行

./bin/kafka-features.sh upgrade --metadata 3.5 - 请注意,集群元数据版本升级后,无法降级到预生产 3.0.x、3.1.x 或 3.2.x 版本。 但是,可以降级到生产版本,例如 3.3-IV0、3.3-IV1 等。

从任何版本 0.8.x 到 3.3.x 升级到 3.4.0

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.3,3.2等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.3,3.2等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为3.4. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将每个代理的 log.message.format.version 更改为 3.4,然后逐个重新启动它们。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

将基于 KRaft 的集群从任何版本 3.0.x 升级到 3.4.0 到 3.3.x

如果您从 3.3.0 之前的版本升级,请参阅下面的说明。将 metadata.version 更改为最新版本后,将无法降级到 3.3-IV0 之前的版本。

对于滚动升级:

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。

- 验证集群的行为和性能后,通过运行

./bin/kafka-features.sh upgrade --metadata 3.4 - 请注意,集群元数据版本升级后,无法降级到预生产 3.0.x、3.1.x 或 3.2.x 版本。 但是,可以降级到生产版本,例如 3.3-IV0、3.3-IV1 等。

3.4.0 中的显著更改

- 从 Apache Kafka 3.4.0 开始,我们添加了一个系统属性(“org.apache.kafka.disallowed.login.modules”)来禁用有问题的 SASL JAAS 配置中的登录模块使用情况。此外,默认情况下,Apache Kafka 3.4.0 中禁用了 “com.sun.security.auth.module.JndiLoginModule”。

从任何版本 0.8.x 到 3.2.x 升级到 3.3.1

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.2,3.1等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.2,3.1等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为3.3. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 更改为 3.3,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

将基于 KRaft 的集群从任何版本 3.0.x 升级到 3.3.1 到 3.2.x

如果您从 3.3.1 之前的版本升级,请参阅下面的说明。将 metadata.version 更改为最新版本后,将无法降级到 3.3-IV0 之前的版本。

对于滚动升级:

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。

- 验证集群的行为和性能后,通过运行

./bin/kafka-features.sh upgrade --metadata 3.3 - 请注意,集群元数据版本升级后,无法降级到预生产 3.0.x、3.1.x 或 3.2.x 版本。但是,可以降级到生产版本,例如 3.3-IV0、3.3-IV1 等。

3.3.1 中的显著更改

- KRaft 模式可用于新集群的生产环境。有关更多详细信息(包括限制),请参阅 KIP-833。

- 默认情况下用于无键记录的分区程序已得到改进,以避免在一个或多个代理速度较慢时出现病态行为。

新逻辑可能会影响批处理行为,可以使用

batch.size和/或linger.ms配置设置。 可以通过设置partitioner.class=org.apache.kafka.clients.producer.internals.DefaultPartitioner. 有关更多详细信息,请参阅 KIP-794。 - 如上所述,现在 KRaft 集群的升级过程与基于 ZK 的集群略有不同。

- 引入了新的 API

addMetricIfAbsent自Metrics这将创建一个新的 Metric(如果不存在)或返回相同的 Metric 如果已经注册。请注意,此行为与addMetricAPI 会抛出一个IllegalArgumentException什么时候 尝试创建已存在的量度。(有关详细信息,请参阅 KIP-843)。

从任何版本 0.8.x 到 3.1.x 升级到 3.2.0

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.1,3.0等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.1,3.0等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为3.2. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 更改为 3.2,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

3.2.0 中的显著变化

- 如果未设置冲突配置,则默认情况下会启用生产者的幂等性。当向 2.8.0 之前的 broker 生产时,

这

IDEMPOTENT_WRITE需要权限。检查兼容性 部分了解 KIP-679 的 THE MissAV.com 的 MissAV.com 的 MissAV.com |在 3.0.0 和 3.1.0 中,一个错误阻止了这个默认值的应用。 这意味着幂等性将保持禁用状态,除非用户明确设置enable.idempotence设置为 true (有关更多详细信息,请参阅 KAFKA-13598)。 此问题已修复,默认值已在 3.0.1、3.1.1 和 3.2.0 中正确应用。 - 一个值得注意的例外是 Connect,默认情况下,它对其所有 producer 来统一支持使用各种 Kafka 代理版本。 用户可以更改此行为,以便为部分或全部生产者启用幂等性 通过 Connect worker 和/或 connector 配置。Connect 可以启用幂等生产者 在将来的主要版本中默认。

- 出于安全考虑,Kafka 已将 log4j 替换为 reload4j。

这仅影响指定日志记录后端 (

connect-runtime和kafka-tools就是两个这样的例子)。 许多模块,包括kafka-clients,请让应用程序指定日志记录后端。 更多信息可以在 reload4j 上找到。 依赖于 Kafka 项目中受影响的模块的项目应使用 slf4j-log4j12 版本 1.7.35 或更高版本,或者 slf4j-reload4j 以避免由日志记录框架引起的可能兼容性问题。 - 示例连接器

FileStreamSourceConnector和FileStreamSinkConnector一直 从默认 Classpath 中删除。要在 Kafka Connect 独立或分布式模式下使用它们,它们需要 显式添加,例如CLASSPATH=./libs/connect-file-3.2.0.jar ./bin/connect-distributed.sh.

从任何版本 0.8.x 升级到 3.1.0 到 3.0.x

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.0,2.8等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

3.0,2.8等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为3.1. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 更改为 3.1,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

3.1.1 中的显著更改

- 如果未设置冲突配置,则默认情况下会启用生产者的幂等性。当向 2.8.0 之前的 broker 生产时,

这

IDEMPOTENT_WRITE需要权限。检查兼容性 部分了解 KIP-679 的 THE MissAV.com 的 MissAV.com 的 MissAV.com |一个错误阻止了生产者幂等默认值的应用,这意味着除非用户 显式设置enable.idempotence设置为 true。请参阅 KAFKA-13598 更多细节。此问题已修复,默认值已正确应用。 - 一个值得注意的例外是 Connect,默认情况下,它对其所有 producer 来统一支持使用各种 Kafka 代理版本。 用户可以更改此行为,以便为部分或全部生产者启用幂等性 通过 Connect worker 和/或 connector 配置。Connect 可以启用幂等生产者 在将来的主要版本中默认。

- 出于安全考虑,Kafka 已将 log4j 替换为 reload4j。

这仅影响指定日志记录后端 (

connect-runtime和kafka-tools就是两个这样的例子)。 许多模块,包括kafka-clients,请让应用程序指定日志记录后端。 更多信息可以在 reload4j 上找到。 依赖于 Kafka 项目中受影响的模块的项目应使用 slf4j-log4j12 版本 1.7.35 或更高版本,或者 slf4j-reload4j 以避免由日志记录框架引起的可能兼容性问题。

3.1.0 中的显著更改

- Apache Kafka 支持 Java 17。

- 以下指标已被弃用:

bufferpool-wait-time-total,io-waittime-total, 和iotime-total.请使用bufferpool-wait-time-ns-total,io-wait-time-ns-total, 和io-time-ns-total相反。有关更多详细信息,请参阅 KIP-773。 - IBP 3.1 将主题 ID 作为 KIP-516 的一部分引入 FetchRequest。

从任何版本 0.8.x 到 2.8.x 升级到 3.0.1

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.8,2.7等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.8,2.7等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为3.0. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 修改为 3.0,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

3.0.1 中的显著更改

- 如果未设置冲突配置,则默认情况下会启用生产者的幂等性。当向 2.8.0 之前的 broker 生产时,

这

IDEMPOTENT_WRITE需要权限。检查兼容性 部分了解 KIP-679 的 THE MissAV.com 的 MissAV.com 的 MissAV.com |一个错误阻止了生产者幂等默认值的应用,这意味着除非用户 显式设置enable.idempotence设置为 true。请参阅 KAFKA-13598 更多细节。此问题已修复,默认值已正确应用。

3.0.0 中的显著更改

- 默认情况下,创建者具有更强的传输保证:

idempotence已启用,并且acks设置为all而不是1. 有关详细信息,请参阅 KIP-679。 在 3.0.0 和 3.1.0 中,一个错误阻止了幂等默认值的应用,这意味着除非用户明确设置enable.idempotence设置为 true。请注意,该 bug 不会影响acks=all改变。有关更多详细信息,请参阅 KAFKA-13598。 此问题已修复,默认值已在 3.0.1、3.1.1 和 3.2.0 中正确应用。 - Java 8 和 Scala 2.12 支持自 Apache Kafka 3.0 起已弃用,并将在 Apache Kafka 4.0 中删除。 有关更多详细信息,请参阅 KIP-750 和 KIP-751。

- ZooKeeper 已升级到版本 3.6.3。

- KRaft 模式的预览版可用,但无法从 2.8 Early Access 版本升级到它。看

这

config/kraft/README.md文件了解详细信息。 - 发布 tarball 不再包含 test、sources、javadoc 和 test sources jar。这些仍会发布到 Maven Central 存储库。

- 现在,运行时类路径中提供了许多实现依赖项 jar 而不是 compile 和 runtime 类路径。升级后的编译错误可以通过显式添加缺少的依赖项 jar 来修复 或更新应用程序以不使用内部类。

- 使用者配置的默认值

session.timeout.ms由 10 秒增加至 45 秒。有关更多详细信息,请参阅 KIP-735。 - 代理配置

log.message.format.version和 Topic 配置message.format.version已被弃用。 这两个配置的值始终假定为3.0如果inter.broker.protocol.version是3.0或更高。 如果log.message.format.version或message.format.version设置,我们建议在清除inter.broker.protocol.version升级到 3.0。这将避免潜在的兼容性问题,如果inter.broker.protocol.version被降级。有关更多详细信息,请参阅 KIP-724。 - Streams API 删除了版本 2.5.0 或更早版本中不推荐使用的所有已弃用的 API。 有关已删除 API 的完整列表,请参阅详细的 Kafka Streams 升级说明。

- Kafka Streams 不再依赖于 “connect:json” 模块 (KAFKA-5146)。 依赖此传递依赖项的项目必须显式声明它。

- 通过

principal.builder.class现在必须实现KafkaPrincipalSerde接口以允许在 broker 之间进行转发。有关使用 KafkaPrincipalSerde 的更多详细信息,请参阅 KIP-590。 - 许多已弃用的类、方法和工具已从

clients,connect,core和tools模块: - The Scala

Authorizer,SimpleAclAuthorizer,并且已删除相关类。请使用 JavaAuthorizer和AclAuthorizer相反。 - 这

Metric#value()方法已删除 (KAFKA-12573)。 - 这

Sum和Total类已删除 (KAFKA-12584)。 请使用WindowedSum和CumulativeSum相反。 - 这

Count和SampledTotal类被删除。请使用WindowedCount和WindowedSum相反。 - 这

PrincipalBuilder,DefaultPrincipalBuilder和ResourceFilter类被删除。 - 从

SslConfigs,SaslConfigs,AclBinding和AclBindingFilter. - 这

Admin.electedPreferredLeaders()方法。请使用Admin.electLeaders相反。 - 这

kafka-preferred-replica-election命令行工具已删除。请使用kafka-leader-election相反。 - 这

--zookeeper选项已从kafka-topics和kafka-reassign-partitions命令行工具。 请使用--bootstrap-server相反。 - 在

kafka-configs命令行工具、--zookeeper选项仅支持更新 SCRAM 凭证配置和描述/更新代理未运行时的动态代理配置。请使用--bootstrap-server用于其他配置作。 - 这

ConfigEntry构造函数已删除 (KAFKA-12577)。 请改用剩余的 public 构造函数。 - config 值

default对于客户端配置client.dns.lookup已被删除。在不太可能的情况下 如果您显式设置了此配置,我们建议将配置保留为未设置 (use_all_dns_ips默认使用)。 - 这

ExtendedDeserializer和ExtendedSerializer类已被删除。请使用Deserializer和Serializer相反。 - 这

close(long, TimeUnit)方法已从 producer、consumer 和 admin 客户端中删除。请使用close(Duration). - 这

ConsumerConfig.addDeserializerToConfig和ProducerConfig.addSerializerToConfig方法 被删除。这些方法不是公共 API,因此没有替代方法。 - 这

NoOffsetForPartitionException.partition()方法已删除。请使用partitions()相反。 - 默认的

partition.assignment.strategy更改为 “[RangeAssignor, CooperativeStickyAssignor]”, 默认情况下,它将使用 RangeAssignor,但允许升级到 CooperativeStickyAssignor,只需一次滚动反弹即可从列表中删除 RangeAssignor。 有关更多详细信息,请在此处查看客户端升级路径指南。 - The Scala

kafka.common.MessageFormatter已删除。请使用 Javaorg.apache.kafka.common.MessageFormatter. - 这

MessageFormatter.init(Properties)方法已删除。请使用configure(Map)相反。 - 这

checksum()方法已从ConsumerRecord和RecordMetadata.信息 格式 v2(自 0.11 起一直是默认值)将校验和从记录批次移动到记录批次。因此,这些方法 没有意义,也没有替代品。 - 这

ChecksumMessageFormatter类已删除。它不是公共 API 的一部分,但可能已被使用 跟kafka-console-consumer.sh.它报告了每条记录的校验和,但一直不支持 从 Message Format V2. - 这

org.apache.kafka.clients.consumer.internals.PartitionAssignor类已被删除。请使用org.apache.kafka.clients.consumer.ConsumerPartitionAssignor相反。 - 这

quota.producer.default和quota.consumer.default配置已删除 (KAFKA-12591)。 必须改用动态配额默认值。 - 这

port和host.name配置已删除。请使用listeners相反。 - 这

advertised.port和advertised.host.name配置已删除。请使用advertised.listeners相反。 - 已弃用的 worker 配置

rest.host.name和rest.port已从 Kafka Connect 工作程序配置中删除 (KAFKA-12482)。 请使用listeners相反。 - 这

Producer#sendOffsetsToTransaction(Map offsets, String consumerGroupId)方法已弃用。请使用Producer#sendOffsetsToTransaction(Map offsets, ConsumerGroupMetadata metadata)相反,其中ConsumerGroupMetadata可以通过以下方式检索KafkaConsumer#groupMetadata()以获得更强的语义。请注意,完整的使用者组元数据集仅为 被 broker 或 2.5 或更高版本理解,因此您必须升级 Kafka 集群以获得更强的语义。否则,你可以直接通过 在new ConsumerGroupMetadata(consumerGroupId)与较老的经纪人合作。有关更多详细信息,请参阅 KIP-732。 - 连接

internal.key.converter和internal.value.converter属性已被完全删除。 自版本 2.0.0 起,这些 Connect 工作线程属性的使用已被弃用。 Worker 现在被硬编码为使用 JSON 转换器schemas.enable设置为false.如果您的集群一直在使用 使用不同的内部密钥或值转换器,您可以按照 KIP-738 中概述的迁移步骤安全地将 Connect 集群升级到 3.0。 - 基于 Connect 的 MirrorMaker (MM2) 包括对支持的更改

IdentityReplicationPolicy,在不重命名主题的情况下启用复制。 现有的DefaultReplicationPolicy仍默认使用,但可以通过replication.policyconfiguration 属性。这对于从旧版 MirrorMaker (MM1) 迁移的用户或 具有简单单向复制拓扑的用例,其中不需要主题重命名。请注意,IdentityReplicationPolicy与DefaultReplicationPolicy无法阻止基于主题名称的复制周期,因此在构建 复制拓扑。 - 原始 MirrorMaker (MM1) 和相关类已被弃用。请使用基于 Connect 的 MirrorMaker (MM2),如异地复制部分所述。

从任何版本 0.8.x 升级到 2.7.x 到 2.7.1

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.7,2.6等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.7,2.6等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为2.8. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将每个代理上的 log.message.format.version 更改为 2.8,然后逐个重新启动它们。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

2.8.0 中的显著变化

- 2.8.0 版本向 KIP-679 中引入的授权方接口添加了一种新方法。 动机是解锁我们的未来计划,以默认启用最强的消息传递保证。 自定义授权方应考虑提供更高效的实现,以支持审核日志记录和任何自定义配置或访问规则。

- IBP 2.8 作为 KIP-516 的一部分,为主题引入了主题 ID。 使用 ZooKeeper 时,此信息存储在 TopicZNode 中。如果集群已降级到以前的 IBP 或版本, 将来的主题不会获得主题 ID,并且不能保证主题将在 ZooKeeper 中保留其主题 ID。 这意味着在再次升级时,某些主题或所有主题将被分配新的 ID。

- Kafka Streams 引入了类型安全的

split()运算符作为 deprecated 的替代品KStream#branch()方法 (参见 KIP-418)。

从任何版本 0.8.x 升级到 2.7.0 到 2.6.x

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.6,2.5等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.6,2.5等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为2.7. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 更改为 2.7,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

2.7.0 中的显著变化

- 2.7.0 版本包括 KIP-595 中指定的核心 Raft 实现。 有一个单独的 “raft” 模块,包含大部分 logic。在与 controller 完成后,用户可以使用一个独立的服务器来测试 性能。有关详细信息,请参阅 raft 模块中的 README.md

- KIP-651 增加了对将 PEM 文件用于密钥和信任存储的支持。

- KIP-612 增加了对强制执行代理范围和每个侦听器连接创建速率的支持。2.7.0 版本包含 KIP-612 的第一部分,动态配置将在 2.8.0 版本中推出。

- 能够限制主题和分区创建,或者 主题删除以防止集群受到 KIP-599 的损害

- 当 Kafka 中提供新功能时,有两个主要问题:

- Kafka 客户端如何了解代理功能?

- 经纪人如何决定启用哪些功能?

- 能够使用

ConsoleConsumer现在可以 通过 KIP-431 - KIP-554 的加入继续朝着从 Kafka 中删除 Zookeeper 的目标迈进。KIP-554 的加入 意味着您不必再直接连接到 ZooKeeper 来管理 SCRAM 凭证。

- 更改现有侦听器的 non-re-configurable configs 导致

InvalidRequestException. 相比之下,之前的(意外的)行为会导致更新的配置被持久化。 但事实并非如此 生效,直到 Broker 重新启动。有关更多讨论,请参阅 KAFKA-10479。 看DynamicBrokerConfig.DynamicSecurityConfigs和SocketServer.ListenerReconfigurableConfigs对于现有侦听器支持的 reconfigurable configs。 - Kafka Streams 在 KStreams DSL 中添加了对滑动窗口聚合的支持。

- 对状态存储进行反向迭代,使用 KIP-617 实现更高效的最新更新搜索

- Kafka Steams 中的端到端延迟指标,请参阅 KIP-613 了解更多详情

- Kafka Streams 使用 KIP-607 添加了报告默认 RocksDB 属性的指标

- KIP-616 中更好的 Scala 隐式 Serdes 支持

从任何版本 0.8.x 升级到 2.6.0 到 2.5.x

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.5,2.4等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.5,2.4等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为2.6. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 修改为 2.6,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

2.6.0 中的显著变化

- Kafka Streams 添加了一种新的处理模式(需要代理 2.5 或更高版本),以改进应用程序 使用 Exactly-Once 保证的可扩展性 (参见 KIP-447)

- 默认情况下,Java 11 或更高版本已启用 TLSv1.3。如果 两者都支持它,否则回退到 TLSv1.2。有关更多详细信息,请参阅 KIP-573。

- 的

client.dns.lookup配置已从default自use_all_dns_ips.如果主机名解析为多个 IP 地址,则客户端和代理现在将 尝试按顺序连接到每个 IP,直到成功建立连接。有关更多详细信息,请参阅 KIP-602。 NotLeaderForPartitionException已弃用并替换为NotLeaderOrFollowerException. Fetch 请求和其他仅用于 leader 或 follower 的请求返回 NOT_LEADER_OR_FOLLOWER(6) 而不是 REPLICA_NOT_AVAILABLE(9) 如果代理不是副本,请确保所有客户端在重新分配期间将此暂时性错误作为可重试异常处理。

从任何版本 0.8.x 到 2.4.x 升级到 2.5.0

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.4,2.3等) - log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

2.4,2.3等)

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION 的

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为2.5. - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将每个代理上的 log.message.format.version 更改为 2.5,然后逐个重新启动它们。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

- 重新分配工具有几项显著变化

kafka-reassign-partitions.sh在 KIP-455 完成后。 此工具现在需要--additional标志,以便在更改 主动重新分配。现在可以使用--cancel命令。最后,使用--zookeeper已被弃用,取而代之的是--bootstrap-server.有关更多详细信息,请参阅 KIP。

2.5.0 中的显著更改

- 什么时候

RebalanceProtocol#COOPERATIVE,Consumer#poll仍可返回数据 当它处于消费者仍然拥有的那些分区的再平衡过程中;另外Consumer#commitSync现在可能会抛出一个非致命的RebalanceInProgressException通知 用户此类事件,为了区分致命的CommitFailedException并允许 users 完成正在进行的再平衡,然后重新尝试为那些仍然拥有的分区提交偏移量。 - 为了提高典型网络环境中的弹性,默认值

zookeeper.session.timeout.ms由 6 秒增加到 18 秒,并且replica.lag.time.max.ms从 10 秒到 30 秒。 - 新的 DSL 运算符

cogroup()已添加,以便一次将多个流聚合在一起。 - 添加了一个新的

KStream.toTable()用于将输入事件流转换为 KTable 的 API。 - 添加了新的 Serde 类型

Void表示 Input 主题中的 Null 键或 Null 值。 - 荒废的

UsePreviousTimeOnInvalidTimestamp并将其替换为UsePartitionTimeOnInvalidTimeStamp. - 通过添加待处理的偏移隔离机制和更强的事务提交,改进了 exactly-once 语义 一致性检查,这大大简化了可扩展的 Exactly-Once 应用程序的实现。 我们还在 examples 文件夹下添加了一个新的 exactly-once 语义代码示例。查看 KIP-447 了解完整详细信息。

- 添加了新的公共 API

KafkaStreams.queryMetadataForKey(String, K, Serializer) to get detailed information on the key being queried. It provides information about the partition number where the key resides in addition to hosts containing the active and standby partitions for the key. - 通过弃用,支持查询过时的存储(以实现高可用性)和属于特定分区的存储

KafkaStreams.store(String, QueryableStoreType)并将其替换为KafkaStreams.store(StoreQueryParameters). - 添加了一个新的公共 API,用于访问实例本地存储的滞后信息,其中包含

KafkaStreams.allLocalStorePartitionLags(). - Scala 2.11 不再受支持。有关详细信息,请参阅 KIP-531。

- 包中的所有 Scala 类

kafka.security.auth已被弃用。请参阅 KIP-504,了解 2.4.0 中添加的新 Java 授权方 API 的详细信息。请注意,kafka.security.auth.Authorizer和kafka.security.auth.SimpleAclAuthorizer在 2.4.0 中已弃用。 - TLSv1 和 TLSv1.1 默认处于禁用状态,因为它们具有已知的安全漏洞。现在只有 TLSv1.2

默认启用。您可以通过在配置选项中显式启用 TLSv1 和 TLSv1.1 来继续使用它们

ssl.protocol和ssl.enabled.protocols. - ZooKeeper 已升级到 3.5.7,如果 3.4 数据目录中没有快照文件,则从 3.4.X 到 3.5.7 的 ZooKeeper 升级可能会失败。

这通常发生在测试升级中,其中 ZooKeeper 3.5.7 尝试加载尚未创建快照文件的现有 3.4 数据目录。

有关此问题的更多详细信息,请参阅 ZOOKEEPER-3056。

ZOOKEEPER-3056 中给出了一个修复方法,即将

snapshot.trust.empty=trueconfig 中zookeeper.properties升级前。 - ZooKeeper 版本 3.5.7 支持与 ZooKeeper 的 TLS 加密连接,无论是否使用客户端证书, 以及其他 Kafka 配置可用于利用这一点。 有关详细信息,请参阅 KIP-515。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x、0.11.0.x、1.0.x、1.1.x、2.0.x 或 2.1.x 或 2.2.x 或 2.3.x 升级到 2.4.0

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.10.0、0.11.0、1.0、2.0、2.2)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (0.11.0, 1.0, 1.1, 2.0, 2.1, 2.2, 2.3).

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 2.4。 - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 更改为 2.4,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

其他升级说明:

- ZooKeeper 已升级到 3.5.6。如果 3.4 数据目录中没有快照文件,则 ZooKeeper 从 3.4.X 升级到 3.5.6 可能会失败。

这通常发生在测试升级中,其中 ZooKeeper 3.5.6 尝试加载尚未创建快照文件的现有 3.4 数据目录。

有关此问题的更多详细信息,请参阅 ZOOKEEPER-3056。

ZOOKEEPER-3056 中给出了一个修复方法,即将

snapshot.trust.empty=trueconfig 中zookeeper.properties升级前。但是,我们在使用snapshot.trust.empty=trueconfig。有关该问题的更多详细信息,请参阅 ZOOKEEPER-3644。 因此,我们建议将空快照文件复制到 3.4 数据目录 如果 3.4 数据目录中没有快照文件。有关解决方法的更多详细信息,请参阅 ZooKeeper 升级常见问题解答。 - 在 ZooKeeper 3.5 中添加的基于 Jetty 的嵌入式 AdminServer。

AdminServer 在 ZooKeeper 中默认启用,并在端口 8080 上启动。

默认情况下,AdminServer 在 ZooKeeper 配置(

zookeeper.properties) 由 Apache Kafka 发行版提供。 请务必更新您的本地zookeeper.properties文件替换为admin.enableServer=false如果您希望禁用 AdminServer。 请参考 AdminServer 配置 AdminServer。

2.4.0 中的显著变化

- 添加了用于分区重新分配的新 Admin API。由于 Kafka 传播重新分配信息的方式发生了变化, 升级到新版本时,在失败的边缘情况下可能会丢失重新分配状态。建议不要在升级时开始重新分配。

- ZooKeeper 已从 3.4.14 升级到 3.5.6。新版本支持 TLS 和动态重新配置。

- 这

bin/kafka-preferred-replica-election.sh命令行工具已弃用。它已被bin/kafka-leader-election.sh. - 方法

electPreferredLeaders在 Java 中AdminClientclass 已被弃用,取而代之的是electLeaders. - Scala 代码利用

NewTopic(String, int, short)构造函数将需要显式调用toShort在第二个文本上。 - 构造函数中的参数

GroupAuthorizationException(String)现在用于指定异常消息。 以前,它指的是授权失败的组。这样做是为了与其他异常类型保持一致,并 避免潜在的误用。构造函数TopicAuthorizationException(String)之前用于单个 未授权的话题也被类似地改变了。 - 内部的

PartitionAssignorinterface 已弃用并替换为新的ConsumerPartitionAssignor在公共 API 中。一些 方法/签名在两个接口之间略有不同。实现自定义 PartitionAssignor 的用户应尽快迁移到新接口。 - 这

DefaultPartitioner现在使用粘性分区策略。这意味着特定主题的记录具有 null 键且没有分配的分区 将发送到同一分区,直到该批次准备好发送为止。创建新批处理时,将选择新分区。这减少了 produce 的延迟,但 在边缘情况下,它可能会导致记录在分区之间的分布不均匀。通常,用户不会受到影响,但这种差异在测试和 其他情况会在很短的时间内生成记录。 - 阻塞

KafkaConsumer#committed方法已扩展为允许将分区列表作为输入参数,而不是单个分区。 它可以减少客户端和代理之间获取使用者组提交的偏移量的请求/响应迭代。 旧的重载函数已弃用,我们建议用户更改代码以利用新方法(详细信息 可以在 KIP-520 中找到)。 - 我们引入了一个新的

INVALID_RECORDerror 与CORRUPT_MESSAGE错误。 更具体地说,以前,当一批记录作为单个请求的一部分发送到 broker 并且一个或多个记录失败时 由于各种原因(魔术字节不匹配、CRC 校验和错误、日志压缩主题的空键等)导致的验证,整个批次将被拒绝 具有相同的误导性CORRUPT_MESSAGE,并且创建者客户端的调用方将看到来自以下任一 的未来对象RecordMetadata从sendcall 以及Callback#onCompletion(RecordMetadata metadata, Exception exception)现在,有了新的错误代码和改进的异常错误消息,创建者调用者可以更好地了解其发送记录失败的根本原因。 - 我们正在将增量协作再平衡引入客户端的组协议,这允许消费者在再平衡期间保留所有分配的分区

最后,仅撤销那些必须迁移到另一个使用者以实现整体集群平衡的 API。这

ConsumerCoordinator将选择最新的RebalanceProtocol这通常受到 Consumer 的所有支持的 assignor 的支持。您可以使用新的内置CooperativeStickyAssignor或插入您自己的自定义 Cooperative Assignor。待办事项 因此,您必须实现ConsumerPartitionAssignor接口和 includeRebalanceProtocol.COOPERATIVE在 return by 返回的列表中ConsumerPartitionAssignor#supportedProtocols. 然后,您的自定义分配器可以利用ownedPartitions字段在每个使用者的Subscription尽可能将分区归还给以前的所有者。请注意,当 分区要重新分配给另一个消费者,必须将其从新分配中删除,直到它从其原始所有者处撤销。任何必须撤销分区的消费者都将触发 后续再平衡,以允许将已撤销的分区安全地分配给其新所有者。有关更多信息,请参见ConsumerPartitionAssignor RebalanceProtocol javadocs。

要从旧的 (eager) 协议(总是在重新平衡之前撤销所有分区)升级到协作式重新平衡,您必须遵循特定的升级路径以使所有客户端位于同一ConsumerPartitionAssignor支持合作协议。这可以通过两次滚动弹跳来完成,使用CooperativeStickyAssignor例如:在第一个作中,将 “cooperative-sticky” 添加到支持的分配器列表中 对于每个成员(不删除前一个分配者 - 请注意,如果以前使用默认值,则还必须显式包含该分配器)。然后,您可以退回和/或升级它。 一旦整个组都处于 2.4+ 状态,并且所有成员在其支持的分配器中都有 “cooperative-sticky”,则删除其他分配器并执行第二次滚动退回,以便到最后所有成员都只支持 合作协议。有关协作式再平衡协议和升级路径的更多详细信息,请参阅 KIP-429。 - 有一些行为变化

ConsumerRebalanceListener以及新的 API。在侦听器的三个回调中的任何一个期间引发的异常将不再被吞噬,而是被重新引发 一直到Consumer.poll()叫。这onPartitionsLost方法,以允许用户对消费者可能失去其分区所有权的异常情况做出反应 (例如错过了 rebalance)并且无法提交偏移量。默认情况下,这将简单地调用现有的onPartitionsRevokedAPI 与之前的行为保持一致。但请注意,onPartitionsLost不会 当 LOST PARTITIONS 集为空时调用。这意味着,在加入组的新 Consumer 的第一次再平衡开始时,不会调用任何回调。

的语义ConsumerRebalanceListener's当遵循上述 Cooperative Rebalancing 协议时,回调会进一步更改。除了onPartitionsLost,onPartitionsRevoked当已撤销的分区集为空时,也永远不会调用。回调通常仅在再平衡结束时调用,并且仅在要移动到另一个使用者的分区集上调用。这onPartitionsAssigned然而,即使分区集为空,也将始终调用 callback 作为通知用户 Rebalance 事件的一种方式(对于 cooperative 和 eager 都是如此)。有关详细信息 新的回调语义,请参见 ConsumerRebalanceListener javadocs。 - Scala 特征

kafka.security.auth.Authorizer已弃用并替换为新的 Java APIorg.apache.kafka.server.authorizer.Authorizer.鉴权方实现类kafka.security.auth.SimpleAclAuthorizer也被弃用并替换为新的 实现kafka.security.authorizer.AclAuthorizer.AclAuthorizer使用功能 受新 API 支持,以改进授权日志记录,并与SimpleAclAuthorizer. 有关更多详细信息,请参阅 KIP-504。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x、0.11.0.x、1.0.x、1.1.x、2.0.x 或 2.1.x 或 2.2.x 升级到 2.3.0

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION(例如 0.8.2、0.9.0、0.10.0、0.10.1、0.10.2、0.11.0、1.0、1.1)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (0.11.0, 1.0, 1.1, 2.0, 2.1, 2.2).

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 2.3。 - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将每个代理上的 log.message.format.version 更改为 2.3,然后逐个重新启动它们。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

2.3.0 中的显著变化

- 我们正在为 Kafka Connect 引入一种基于增量协作再平衡的新再平衡协议。 新协议不要求在 Connect 工作程序之间的再平衡阶段停止所有任务。相反,只需要交换的任务 在 worker 之间停止,并在后续 rebalance 中启动。从 2.3.0 开始,新的 Connect 协议默认启用。 有关其工作原理以及如何启用预先再平衡的旧行为的更多详细信息,请查看增量协作再平衡设计。

- 我们正在向消费者用户引入静态成员资格。此功能可减少正常应用程序升级或滚动退回期间不必要的重新平衡。 有关如何使用它的更多详细信息,请查看静态成员资格设计。

- Kafka Streams DSL 会切换其使用的存储类型。虽然此更改主要对用户透明,但在某些极端情况下可能需要更改代码。 有关更多详细信息,请参阅 Kafka Streams 升级部分。

- Kafka Streams 2.3.0 需要 0.11 格式或更高版本的消息格式,并且不适用于较旧的消息格式。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x、0.11.0.x、1.0.x、1.1.x、2.0.x 或 2.1.x 升级到 2.2.0

如果您从 2.1.x 之前的版本升级,请参阅下面的说明,了解用于存储使用者偏移量的架构的更改。 将 inter.broker.protocol.version 更改为最新版本后,将无法降级到 2.1 之前的版本。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION(例如 0.8.2、0.9.0、0.10.0、0.10.1、0.10.2、0.11.0、1.0、1.1)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (0.11.0, 1.0, 1.1, 2.0).

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 2.2。 - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 修改为 2.2,然后逐个重启。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

2.2.1 中的显著更改

- Kafka Streams 2.2.1 需要 0.11 或更高的消息格式,并且不适用于较旧的消息格式。

2.2.0 中的显著变化

- 默认消费组 ID 由空字符串 () 改为

""null.使用新的默认 Group ID 的 Consumer 将无法订阅 Topic, 以及 fetch 或 commit offsets。作为使用者组 ID 的空字符串已弃用,但在将来的主要版本之前将受支持。依赖空字符串组 ID 的旧客户端现在将 必须显式地将其作为其 consumer 配置的一部分提供。有关更多信息,请参阅 KIP-289。 - 这

bin/kafka-topics.sh命令行工具现在能够直接连接到代理--bootstrap-server而不是 Zookeeper。旧的--zookeeper选项目前仍然可用。请阅读 KIP-377 了解更多信息。 - Kafka Streams 依赖于需要 MacOS 10.13 或更高版本的较新版本的 RocksDB。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x、0.11.0.x、1.0.x、1.1.x 或 2.0.0 升级到 2.1.0

请注意,2.1.x 包含对用于存储使用者偏移量的内部架构的更改。升级后 complete,则无法降级到以前的版本。有关更多详细信息,请参阅下面的滚动升级说明。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION(例如 0.8.2、0.9.0、0.10.0、0.10.1、0.10.2、0.11.0、1.0、1.1)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (0.11.0, 1.0, 1.1, 2.0).

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。完成此作后, Broker 将运行最新版本,您可以验证集群的行为和性能是否符合预期。 如果有任何问题,此时仍然可以降级。

- 验证集群的行为和性能后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 2.1。 - 逐个重启 broker,新协议版本才能生效。一旦代理开始使用最新的 协议版本,则无法再将集群降级到旧版本。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将每个代理上的 log.message.format.version 更改为 2.1,然后逐个重新启动它们。请注意,较旧的 Scala 客户端 不再维护,不支持 0.11 中引入的 message 格式,从而避免转换成本 (或利用 Exactly once 语义)、 必须使用较新的 Java 客户端。

其他升级说明:

- 此版本中的偏移过期语义略有变化。根据新的语义,组中分区的偏移量将 当组订阅了相应的主题并且仍然处于活动状态(具有活跃的使用者)时,不会被删除。如果 group 变为 empty 在默认偏移保持期(或代理设置的保持期)过后,将删除其所有偏移量(除非该组变为 再次激活)。默认情况下,与不使用 Kafka 组管理的独立(简单)消费者关联的偏移量将被删除 offset 保留期(或 Broker 设置的保留期)自上次提交以来已过去。

- 控制台使用者的

enable.auto.commitproperty (当 nogroup.id现在设置为false. 这是为了避免污染使用者协调器缓存,因为自动生成的组不太可能被其他使用者使用。 - 生产者

retriesconfig 已更改为Integer.MAX_VALUE,正如我们介绍delivery.timeout.ms在 KIP-91 中, 它为发送记录和从 broker 接收确认之间的总时间设置上限。默认情况下, 传输超时设置为 2 分钟。 - 默认情况下,MirrorMaker 现在会覆盖

delivery.timeout.ms自Integer.MAX_VALUE什么时候 配置 Producer。如果您已覆盖retries为了更快地失败, 您将需要重写delivery.timeout.ms. - 这

ListGroupAPI 现在期望作为推荐的替代方案Describe Group对用户应能够列出的组的访问权限。 即使旧的Describe Cluster为了向后兼容,仍然支持 access,不建议将其用于此 API。 - KIP-336 弃用了 ExtendedSerializer 和 ExtendedDeserializer 接口以及 传播 Serializer 和 Deserializer 的用法。ExtendedSerializer 和 ExtendedDeserializer 随 KIP-82 一起引入,用于为序列化器和反序列化程序提供记录标头 以 Java 7 兼容的方式。现在,我们整合了这些接口,因为 Java 7 支持已经被放弃了。

2.1.0 中的显著更改

- Jetty 已升级到 9.4.12,默认情况下不包括 TLS_RSA_* 密码,因为它们不支持转发 保密性,请参阅 https://github.com/eclipse/jetty.project/issues/2807 了解更多信息。

- 在以下情况下,控制器会自动启用 Unclean leader 选举

unclean.leader.election.enableconfig 使用按主题的 config override 动态更新。 - 这

AdminClient添加了一个方法AdminClient#metrics().现在,任何使用AdminClient可以获取更多信息 和 insight 通过查看从AdminClient.了解更多信息 参见 KIP-324 - Kafka 现在支持从 KIP-110 开始的 Zstandard 压缩。 您必须升级代理和客户端才能使用它。2.1.0 之前的使用者将无法从使用 Z标准压缩,因此在所有下游使用者都升级之前,您不应为主题启用它。有关更多详细信息,请参阅 KIP。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x、0.11.0.x、1.0.x 或 1.1.x 升级到 2.0.0

Kafka 2.0.0 引入了有线协议更改。通过遵循下面推荐的滚动升级计划, 您保证在升级期间不会出现停机时间。但是,请在升级之前查看 2.0.0 中的显著更改。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION(例如 0.8.2、0.9.0、0.10.0、0.10.1、0.10.2、0.11.0、1.0、1.1)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (0.11.0, 1.0, 1.1).

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。

- 升级整个集群后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 2.0。 - 逐个重启 broker,新协议版本才能生效。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 修改为 2.0,然后逐个重启。请注意,较旧的 Scala 使用者 不支持 0.11 中引入的新消息格式,因此为了避免下转换(或 利用 Exactly Once 语义),则必须使用较新的 Java 使用者。

其他升级说明:

- 如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并重新启动它们。他们将开始 默认使用新协议。

- 升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。 消息格式版本也是如此。

- 如果您在 Kafka Streams 代码中使用 Java8 方法引用,则可能需要更新代码以解决方法歧义。 仅热交换 jar 文件可能不起作用。

- 不应将 ACL 添加到带前缀的资源中,

(在 KIP-290 中添加),

直到集群中的所有代理都已更新。

注意:如果集群再次降级,则即使在集群完全升级后,添加到集群的任何带前缀的 ACL 也将被忽略。

2.0.0 中的显著更改

- KIP-186 将默认偏移保留时间从 1 天增加到 7 天。这使得在不经常提交的应用程序中 “丢失” 偏移量的可能性较小。它还会增加活动的偏移量集,因此会增加代理的内存使用量。请注意,控制台使用者目前默认启用偏移量提交,并且可能是大量偏移量的来源,此更改现在将保留 7 天,而不是 1 天。您可以通过设置 broker config 来保留现有行为

offsets.retention.minutes到 1440 年。 - 已删除对 Java 7 的支持,Java 8 现在是所需的最低版本。

- 的默认值

ssl.endpoint.identification.algorithm已更改为https执行主机名验证(否则可能会发生中间人攻击)。设置ssl.endpoint.identification.algorithm转换为空字符串以恢复之前的行为。 - KAFKA-5674 延长了

max.connections.per.ipminimum 到 0,因此允许对入站连接进行基于 IP 的筛选。 - KIP-272 向指标添加了 API 版本标签

kafka.network:type=RequestMetrics,name=RequestsPerSec,request={Produce|FetchConsumer|FetchFollower|...}. 此指标现在变为kafka.network:type=RequestMetrics,name=RequestsPerSec,request={Produce|FetchConsumer|FetchFollower|...},version={0|1|2|3|...}.这将影响 JMX 监控工具,这些工具不会自动聚合。要获取特定请求类型的总数,该工具需要为 更新为跨不同版本聚合。 - KIP-225 更改了指标“records.lag”,以使用主题和分区的标签。名称格式为 “{topic}-{partition}.records-lag” 的原始版本已被删除。

- 自 0.11.0.0 起已弃用的 Scala 使用者已被删除。Java 使用者是推荐的选项 从 0.10.0.0 开始。请注意,即使代理升级到 2.0.0,1.1.0(及更早版本)中的 Scala 使用者也将继续工作。

- 自 0.10.0.0 起已弃用的 Scala 生产者已被删除。Java 生产者是推荐选项 从 0.9.0.0 开始。请注意,Java 生产者中默认分区程序的行为与默认分区程序不同 在 Scala 生产者中。迁移的用户应考虑配置一个保留先前行为的自定义分区程序。 请注意,即使代理升级到 2.0.0,1.1.0(及更早版本)中的 Scala 创建者也将继续工作。

- MirrorMaker 和 ConsoleConsumer 不再支持 Scala 使用者,它们始终使用 Java 使用者。

- ConsoleProducer 不再支持 Scala 生产者,它始终使用 Java 生产者。

- 许多依赖于 Scala 客户端的已弃用工具已被删除:ReplayLogProducer、SimpleConsumerPerformance、SimpleConsumerShell、ExportZkOffsets、ImportZkOffsets、UpdateOffsetsInZK、VerifyConsumerRebalance。

- 已弃用的 kafka.tools.ProducerPerformance 已被删除,请使用 org.apache.kafka.tools.ProducerPerformance。

- 新的 Kafka Streams 配置参数

upgrade.from添加了允许从旧版本进行滚动弹跳升级的功能。 - KIP-284 通过将 Kafka Streams 重新分区主题的默认值设置为

Long.MAX_VALUE. - 更新

ProcessorStateManagerKafka Streams 中用于将状态存储注册到处理器拓扑的 API。有关更多详细信息,请阅读 Streams 升级指南。 - 在早期版本中,Connect 的工作程序配置需要

internal.key.converter和internal.value.converter性能。 在 2.0 中,这些不再是必需的,并且默认为 JSON 转换器。 您可以安全地从 Connect 独立和分布式工作程序配置中删除这些属性:

internal.key.converter=org.apache.kafka.connect.json.JsonConverterinternal.key.converter.schemas.enable=falseinternal.value.converter=org.apache.kafka.connect.json.JsonConverterinternal.value.converter.schemas.enable=false - KIP-266 添加了新的使用者配置

default.api.timeout.ms指定要用于的默认超时KafkaConsumer可能阻止的 API。KIP 还为此类阻塞添加了重载 API 支持指定用于每个 API 的特定超时,而不是使用default.api.timeout.ms. 特别是,新的poll(Duration)添加了 API,它不会阻止动态分区分配。 旧的poll(long)API 已弃用,并将在未来版本中删除。还添加了重载 对于其他KafkaConsumer方法,如partitionsFor,listTopics,offsetsForTimes,beginningOffsets,endOffsets和close那 take in aDuration. - 此外,作为 KIP-266 的一部分,默认值

request.timeout.ms已更改为 30 秒。 之前的值略高于 5 分钟,以考虑再平衡所需的最长时间。 现在,我们将再平衡中的 JoinGroup 请求视为特殊情况,并使用从max.poll.interval.ms对于请求超时。所有其他请求类型都使用定义的超时 由request.timeout.ms - 内部方法

kafka.admin.AdminClient.deleteRecordsBefore已被删除。鼓励用户迁移到org.apache.kafka.clients.admin.AdminClient.deleteRecords. - AclCommand 工具

--producerconvenience 选项在给定主题上使用 KIP-277 更细粒度的 ACL。 - KIP-176 去除

这

--new-consumer所有基于消费者的工具的选项。此选项是多余的,因为新使用者会自动 如果定义了 --bootstrap-server,则使用。 - KIP-290 增加了能力 在带前缀的资源上定义 ACL,例如任何以 'foo' 开头的主题。

- KIP-283 改进了消息下转换

处理,这通常是一项占用大量内存的作。KIP 添加了一种机制,通过该机制,作将变得不那么占用内存

通过一次向下转换分区数据块,这有助于设置内存消耗的上限。随着这一改进,发生了

FetchResponse协议行为,其中代理可能会在响应末尾发送具有无效偏移量的超大消息批次。 使用者客户端必须忽略此类超大消息,就像KafkaConsumer.KIP-283 还添加了新的主题和代理配置

message.downconversion.enable和log.message.downconversion.enable分别 以控制是否启用下转换。禁用后,broker 不会执行任何下转换,而是发送UNSUPPORTED_VERSION错误。 - 动态代理配置选项可以在启动代理之前使用 kafka-configs.sh 存储在 ZooKeeper 中。 此选项可用于避免在 server.properties 中存储明文密码,因为所有密码配置都可以加密存储在 ZooKeeper 中。

- 现在,如果连接尝试失败,将重新解析 ZooKeeper 主机。但是,如果您的 ZooKeeper 主机名解析

添加到多个地址,并且其中一些地址无法访问,那么您可能需要增加连接超时

zookeeper.connection.timeout.ms.

新协议版本

- KIP-279:OffsetsForLeaderEpochResponse v1 引入了分区级别

leader_epoch田。 - KIP-219:提高因违反配额而受到限制的非集群作请求和响应的协议版本。

- KIP-290:提高 ACL 创建、描述和删除请求和响应的协议版本。

升级 1.1 Kafka Streams 应用程序

- 将 Streams 应用程序从 1.1 升级到 2.0 不需要升级代理。 Kafka Streams 2.0 应用程序可以连接到 2.0、1.1、1.0、0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 请注意,在 2.0 中,我们删除了 1.0 之前已弃用的公共 API;利用这些已弃用的 API 的用户需要相应地更改代码。 有关更多详细信息,请参阅 2.0.0 中的 Streams API 更改。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x、0.11.0.x 或 1.0.x 升级到 1.1.x

Kafka 1.1.0 引入了有线协议更改。通过遵循下面推荐的滚动升级计划, 您保证在升级期间不会出现停机时间。但是,请在升级之前查看 1.1.0 中的显著更改。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.8.2、0.9.0、0.10.0、0.10.1、0.10.2、0.11.0、1.0)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION(0.11.0 或 1.0)。

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。

- 升级整个集群后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 1.1。 - 逐个重启 broker,新协议版本才能生效。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将 log.message.format.version 修改为 1.1,然后逐个重启。请注意,较旧的 Scala 使用者 不支持 0.11 中引入的新消息格式,因此为了避免下转换(或 利用 Exactly Once 语义),则必须使用较新的 Java 使用者。

其他升级说明:

- 如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并重新启动它们。他们将开始 默认使用新协议。

- 升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。 消息格式版本也是如此。

- 如果您在 Kafka Streams 代码中使用 Java8 方法引用,则可能需要更新代码以解决方法歧义。 仅热交换 jar 文件可能不起作用。

1.1.1 中的显著变化

- 新的 Kafka Streams 配置参数

upgrade.from添加了允许从版本 0.10.0.x 进行滚动弹跳升级的功能 - 请参阅 Kafka Streams 升级指南 有关此新配置的详细信息。

1.1.0 中的显著变化

- Maven 中的 kafka 工件不再依赖于 log4j 或 slf4j-log4j12。与 kafka-clients 工件类似,用户 现在,可以通过包含适当的 SLF4j 模块(SLF4J-Log4J12、LOGBack 等)来选择日志记录后端。发布 tarball 仍然包括 log4j 和 slf4j-log4j12。

- KIP-225 更改了指标“records.lag”,以使用主题和分区的标签。名称格式为“{topic}-{partition}.records-lag”的原始版本已弃用,并将在 2.0.0 中删除。

- Kafka Streams 在防止代理通信错误方面更健壮。而不是停止 Kafka Streams 客户端并显示致命异常,

Kafka Streams 会尝试自我修复并重新连接到集群。使用新的

AdminClient您可以更好地控制频率 Kafka Streams 重试,并且可以配置精细超时(而不是旧版本中的硬编码重试)。 - Kafka Streams 再平衡时间进一步缩短,使 Kafka Streams 的响应速度更快。

- Kafka Connect 现在支持 Sink 和 Source Connector 中的消息标头,并通过简单的消息转换对其进行作。必须更改连接器才能显式使用它们。新的

HeaderConverter用于控制 Headers 的 (反) 序列化方式,并且默认使用新的 “SimpleHeaderConverter” 来使用值的字符串表示形式。 - 如果启用了 print-data-log,kafka.tools.DumpLogSegments 现在会自动设置 deep-iteration 选项 显式或隐式地由于任何其他选项(如 decoder)而显式或隐式地使用。

新协议版本

升级 1.0 Kafka Streams 应用程序

- 将 Streams 应用程序从 1.0 升级到 1.1 不需要升级代理。 Kafka Streams 1.1 应用程序可以连接到 1.0、0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 有关更多详细信息,请参阅 1.1.0 中的 Streams API 更改。

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x、0.10.2.x 或 0.11.0.x 升级到 1.0.0

Kafka 1.0.0 引入了有线协议更改。通过遵循下面推荐的滚动升级计划, 您保证在升级期间不会出现停机时间。但是,请在升级之前查看 1.0.0 中的显著更改。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果您之前有

覆盖了 Message Format version,则应保留其当前值。或者,如果您要从之前的版本升级

设置为 0.11.0.x,则CURRENT_MESSAGE_FORMAT_VERSION应设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.8.2、0.9.0、0.10.0、0.10.1、0.10.2、0.11.0)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- inter.broker.protocol.version=0.11.0

- log.message.format.version=0.11.0

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。

- 升级整个集群后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 1.0。 - 逐个重启 broker,新协议版本才能生效。

- 如果您已按照上述说明覆盖了消息格式版本,则需要再执行一次滚动重启,以 将其升级到最新版本。所有(或大多数)消费者都升级到 0.11.0 或更高版本后, 将每个 broker 上的 log.message.format.version 更改为 1.0,然后逐个重新启动它们。如果要从 0.11.0 且 log.message.format.version 设置为 0.11.0,则可以更新配置并跳过滚动重启。 请注意,较旧的 Scala consumer 不支持 0.11 中引入的新消息格式,因此为了避免 下转换的性能成本(或利用 Exactly Once 语义), 必须使用较新的 Java 使用者。

其他升级说明:

- 如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并重新启动它们。他们将开始 默认使用新协议。

- 升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。 消息格式版本也是如此。

1.0.2 中的显著变化

- 新的 Kafka Streams 配置参数

upgrade.from添加了允许从版本 0.10.0.x 进行滚动弹跳升级的功能 - 请参阅 Kafka Streams 升级指南 有关此新配置的详细信息。

1.0.1 中的显著变化

- 恢复了 AdminClient 的 Options 类(例如 CreateTopicsOptions、DeleteTopicsOptions 等)与 0.11.0.x 的二进制(但不是源)兼容性在 1.0.0 中被无意中破坏了。

1.0.0 中的显著更改

- 主题删除现在默认启用,因为该功能现在很稳定。希望

要保留之前的行为,应将 broker config

delete.topic.enable自false.请记住,主题删除会删除数据,并且该作是不可逆的(即没有“取消删除”作) - 对于支持时间戳搜索的主题,如果找不到分区的偏移量,则该分区现在包含在搜索结果中,并带有 null 偏移值。以前,分区不包括在 map 中。 进行此更改是为了使搜索行为与不支持时间戳搜索的主题的情况一致。

- 如果

inter.broker.protocol.version是 1.0 或更高版本,代理现在将保持联机以提供副本 在实时日志目录上,即使存在离线日志目录。日志目录可能会因 IOException 而脱机 由硬件故障引起。用户需要监控每个代理的指标offlineLogDirectoryCount检查 是否有离线日志目录。 - 添加了 KafkaStorageException,这是一个可重试的异常。KafkaStorageException 将在响应中转换为 NotLeaderForPartitionException 如果客户端的 FetchRequest 或 ProducerRequest 版本不支持 KafkaStorageException。

- 在默认 JVM 设置中,-XX:+DisableExplicitGC 已替换为 -XX:+ExplicitGCInvokesConcurrent。这有助于 在某些情况下,避免在直接缓冲区分配本机内存期间出现内存不足异常。

- 被覆盖的

handleError方法实现已从 这kafka.api包:FetchRequest,GroupCoordinatorRequest,OffsetCommitRequest,OffsetFetchRequest,OffsetRequest,ProducerRequest和TopicMetadataRequest. 这仅用于代理,但已不再使用,并且尚未维护实现。 为了二进制兼容性,保留了存根实现。 - Java 客户端和工具现在接受任何字符串作为 client-id。

- 已弃用的工具

kafka-consumer-offset-checker.sh已被删除。用kafka-consumer-groups.sh以获取 Consumer Group 详细信息。 - 现在,默认情况下,SimpleAclAuthorizer 会将访问拒绝记录到授权方日志中。

- 身份验证失败现在作为 的子类之一报告给客户端

AuthenticationException. 如果客户端连接身份验证失败,则不会执行重试。 - 习惯

SaslServerimplementations 可能会抛出SaslAuthenticationException提供错误 消息返回给客户端,指示身份验证失败的原因。实现者应注意不要包含 异常消息中不应泄露给未经身份验证的客户端的任何安全关键信息。 - 这

app-info向 JMX 注册以提供版本和提交 ID 的 mbean 将被弃用并替换为 提供这些属性的指标。 - Kafka 指标现在可能包含非数字值。

org.apache.kafka.common.Metric#value()已被弃用,并且 将返回0.0在这种情况下,为了最大限度地降低打破读取每个客户端值的用户的可能性 度量(通过MetricsReporter实现或通过调用metrics()方法)。org.apache.kafka.common.Metric#metricValue()可用于检索数字和非数字度量值。 - 现在,每个 Kafka 速率指标都有一个相应的累积计数指标,其后缀为

-total简化下游处理。例如records-consumed-rate具有相应的 名为records-consumed-total. - Mx4j 仅在 system 属性

kafka_mx4jenable设置为true.由于逻辑 inversion 错误,它之前默认启用,如果kafka_mx4jenable设置为true. - 包装

org.apache.kafka.common.security.auth在 clients 中,jar 已公开并添加到 JavaDocs 中。 以前位于此包中的 Internal 类已移至其他位置。 - 当使用 Authorizer 并且用户对主题没有所需的权限时,代理 将TOPIC_AUTHORIZATION_FAILED错误返回给请求,而不管 broker 上是否存在主题。 如果用户具有所需的权限,但主题不存在,则 UNKNOWN_TOPIC_OR_PARTITION 将返回错误代码。

- config/consumer.properties 文件已更新为使用新的 Consumer Config 属性。

新协议版本

- KIP-112:LeaderAndIsrRequest v1 引入了分区级别

is_new田。 - KIP-112:UpdateMetadataRequest v4 引入了分区级别

offline_replicas田。 - KIP-112:MetadataResponse v5 引入了分区级

offline_replicas田。 - KIP-112:ProduceResponse v4 引入了 KafkaStorageException 的错误代码。

- KIP-112:FetchResponse v6 引入了 KafkaStorageException 的错误代码。

- KIP-152: 添加了 SaslAuthenticate 请求,以启用身份验证失败的报告。此请求将 如果 SaslHandshake 请求版本大于 0,则使用。

升级 0.11.0 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.11.0 升级到 1.0 不需要代理升级。 Kafka Streams 1.0 应用程序可以连接到 0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。 但是,Kafka Streams 1.0 需要 0.10 或更新的消息格式,并且不适用于较旧的消息格式。

- 如果您正在监控流指标,则需要对报告和监控代码中的指标名称进行一些更改,因为指标传感器层次结构已更改。

- 有一些公共 API,包括

ProcessorContext#schedule(),Processor#punctuate()和KStreamBuilder,TopologyBuilder正在被新的 API 弃用。 我们建议您在升级时进行相应的代码更改,这些更改应该非常小,因为新 API 看起来非常相似。 - 有关更多详细信息,请参阅 1.0.0 中的 Streams API 更改。

升级 0.10.2 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.2 升级到 1.0 不需要升级代理。 Kafka Streams 1.0 应用程序可以连接到 1.0、0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 如果您正在监控流指标,则需要对报告和监控代码中的指标名称进行一些更改,因为指标传感器层次结构已更改。

- 有一些公共 API,包括

ProcessorContext#schedule(),Processor#punctuate()和KStreamBuilder,TopologyBuilder正在被新的 API 弃用。 我们建议您在升级时进行相应的代码更改,这些更改应该非常小,因为新 API 看起来非常相似。 - 如果指定 customized

key.serde,value.serde和timestamp.extractor在 Config 中,建议使用其替换的 configure 参数,因为这些配置已被弃用。 - 有关更多详细信息,请参阅 0.11.0 中的 Streams API 更改。

升级 0.10.1 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.1 升级到 1.0 不需要代理升级。 Kafka Streams 1.0 应用程序可以连接到 1.0、0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 您需要重新编译代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 如果您正在监控流指标,则需要对报告和监控代码中的指标名称进行一些更改,因为指标传感器层次结构已更改。

- 有一些公共 API,包括

ProcessorContext#schedule(),Processor#punctuate()和KStreamBuilder,TopologyBuilder正在被新的 API 弃用。 我们建议您在升级时进行相应的代码更改,这些更改应该非常小,因为新 API 看起来非常相似。 - 如果指定 customized

key.serde,value.serde和timestamp.extractor在 Config 中,建议使用其替换的 configure 参数,因为这些配置已被弃用。 - 如果您使用自定义(即用户实现的)时间戳提取器,则需要更新此代码,因为

TimestampExtractor界面已更改。 - 如果您注册自定义指标,则需要更新此代码,因为

StreamsMetric界面已更改。 - 有关更多详细信息,请参阅 1.0.0 中的 Streams API 更改、0.11.0 中的 Streams API 更改和 0.10.2 中的 Streams API 更改。

升级 0.10.0 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.0 升级到 1.0 确实需要升级代理,因为 Kafka Streams 1.0 应用程序只能连接到 0.1、0.11.0、0.10.2 或 0.10.1 代理。

- 有一些 API 更改不向后兼容(有关更多详细信息,请参阅 1.0.0 中的 Streams API 更改、0.11.0 中的 Streams API 更改、0.10.2 中的 Streams API 更改和 0.10.1 中的 Streams API 更改)。 因此,您需要更新并重新编译您的代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 从 0.10.0.x 升级到 1.0.2 需要使用 config 进行两次滚动退回

upgrade.from="0.10.0"设置为第一个升级阶段 (参见 KIP-268)。 作为替代方案,也可以进行离线升级。- 为滚动退回准备应用程序实例,并确保 config

upgrade.from设置为"0.10.0"新版本 0.11.0.3 - 退回应用程序的每个实例一次

- 为新部署的 1.0.2 应用程序实例准备第二轮滚动退回;确保删除 config 的值

upgrade.from - 再次退回应用程序的每个实例以完成升级

- 为滚动退回准备应用程序实例,并确保 config

- 从 0.10.0.x 升级到 1.0.0 或 1.0.1 需要离线升级(不支持滚动弹跳升级)

- 停止所有旧的 (0.10.0.x) 应用程序实例

- 更新您的代码,并将旧代码和 JAR 文件替换为新代码和新 JAR 文件

- 重新启动所有新的(1.0.0 或 1.0.1)应用程序实例

从 0.8.x、0.9.x、0.10.0.x、0.10.1.x 或 0.10.2.x 升级到 0.11.0.0

Kafka 0.11.0.0 引入了新的消息格式版本以及有线协议更改。通过遵循下面推荐的滚动升级计划, 您保证在升级期间不会出现停机时间。但是,请在升级之前查看 0.11.0.0 中的显著更改。

从版本 0.10.2 开始,Java 客户端(生产者和使用者)已获得与旧代理通信的能力。版本 0.11.0 客户端可以与 0.10.0 或更高版本的代理通信。但是,如果您的代理版本低于 0.10.0,则必须升级 Kafka 集群。版本 0.11.0 代理支持 0.8.x 和更新的客户端。

对于滚动升级:

- 更新所有代理上的 server.properties 并添加以下属性。CURRENT_KAFKA_VERSION 是指您

正在升级。CURRENT_MESSAGE_FORMAT_VERSION 是指当前正在使用的消息格式版本。如果你有

之前未覆盖消息格式,则应将 CURRENT_MESSAGE_FORMAT_VERSION 设置为 MATCH CURRENT_KAFKA_VERSION。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.8.2、0.9.0、0.10.0、0.10.1 或 0.10.2)。

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (查看潜在的性能影响) 有关此配置的作用的详细信息。

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。

- 升级整个集群后,通过编辑来增加协议版本

inter.broker.protocol.version并将其设置为 0.11.0,但 不更改log.message.format.version还。 - 逐个重启 broker,新协议版本才能生效。

- 将所有(或大多数)使用者升级到 0.11.0 或更高版本后,将每个使用者的 log.message.format.version 更改为 0.11.0 broker 并逐个重新启动它们。请注意,较旧的 Scala 使用者不支持新的 message 格式,因此要避免 下转换的性能成本(或利用 Exactly once 语义), 必须使用新的 Java 使用者。

其他升级说明:

- 如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并重新启动它们。他们将开始 默认使用新协议。

- 升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。 消息格式版本也是如此。

- 也可以使用主题管理工具 (

bin/kafka-topics.sh) 更新全局设置之前log.message.format.version. - 如果您从 0.10.0 之前的版本升级,则无需先将消息格式更新为 0.10.0 在切换到 0.11.0 之前。

升级 0.10.2 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.2 升级到 0.11.0 不需要升级代理。 Kafka Streams 0.11.0 应用程序可以连接到 0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 如果指定 customized

key.serde,value.serde和timestamp.extractor在 Config 中,建议使用其替换的 configure 参数,因为这些配置已被弃用。 - 有关更多详细信息,请参阅 0.11.0 中的 Streams API 更改。

升级 0.10.1 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.1 升级到 0.11.0 不需要代理升级。 Kafka Streams 0.11.0 应用程序可以连接到 0.11.0、0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 您需要重新编译代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 如果指定 customized

key.serde,value.serde和timestamp.extractor在 Config 中,建议使用其替换的 configure 参数,因为这些配置已被弃用。 - 如果您使用自定义(即用户实现的)时间戳提取器,则需要更新此代码,因为

TimestampExtractor界面已更改。 - 如果您注册自定义指标,则需要更新此代码,因为

StreamsMetric界面已更改。 - 有关更多详细信息,请参阅 0.11.0 中的 Streams API 更改和 0.10.2 中的 Streams API 更改。

升级 0.10.0 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.0 升级到 0.11.0 确实需要升级代理,因为 Kafka Streams 0.11.0 应用程序只能连接到 0.11.0、0.10.2 或 0.10.1 代理。

- 有几个 API 更改不向后兼容(有关详细信息,请参阅 0.11.0 中的 Streams API 更改、0.10.2 中的 Streams API 更改和 0.10.1 中的 Streams API 更改)。 因此,您需要更新并重新编译您的代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 从 0.10.0.x 升级到 0.11.0.3 需要使用 config 进行两次滚动退回

upgrade.from="0.10.0"设置为第一个升级阶段 (参见 KIP-268)。 作为替代方案,也可以进行离线升级。- 为滚动退回准备应用程序实例,并确保 config

upgrade.from设置为"0.10.0"新版本 0.11.0.3 - 退回应用程序的每个实例一次

- 为新部署的 0.11.0.3 应用程序实例准备第二轮滚动退回;确保删除 config 的值

upgrade.from - 再次退回应用程序的每个实例以完成升级

- 为滚动退回准备应用程序实例,并确保 config

- 从 0.10.0.x 升级到 0.11.0.0、0.11.0.1 或 0.11.0.2 需要离线升级(不支持滚动退回升级)

- 停止所有旧的 (0.10.0.x) 应用程序实例

- 更新您的代码,并将旧代码和 JAR 文件替换为新代码和新 JAR 文件

- 重新启动所有新的(0.11.0.0、0.11.0.1 或 0.11.0.2)应用程序实例

0.11.0.3 中的显著变化

- 新的 Kafka Streams 配置参数

upgrade.from添加了允许从版本 0.10.0.x 进行滚动弹跳升级的功能 - 请参阅 Kafka Streams 升级指南 有关此新配置的详细信息。

0.11.0.0 中的显著变化

- Unclean leader 选举现在默认处于禁用状态。新的默认值更倾向于持久性而不是可用性。希望

要保留之前的行为,应将 broker config

unclean.leader.election.enable自true. - 生产者配置

block.on.buffer.full,metadata.fetch.timeout.ms和timeout.ms一直 删除。它们最初在 Kafka 0.9.0.0 中被弃用。 - 这

offsets.topic.replication.factor现在,在自动创建主题时强制执行 Broker Config。内部 自动主题创建将失败并显示 GROUP_COORDINATOR_NOT_AVAILABLE 错误,直到集群大小满足此错误 复制因子要求。 - 使用 snappy 压缩数据时,创建者和代理将使用压缩方案的默认块大小 (2 x 32 KB) 而不是 1 KB,以提高压缩率。有报道称,使用较小的 块大小比使用较大块大小压缩时大 50%。对于快速的情况,具有 5000 个 分区将需要额外的 315 MB JVM 堆。

- 同样,当使用 gzip 压缩数据时,创建者和代理将使用 8 KB 而不是 1 KB 作为缓冲区大小。默认的 因为 gzip 过低(512 字节)。

- 代理配置

max.message.bytes现在适用于一批消息的总大小。 以前,该设置应用于批量压缩消息,或单独应用于非压缩消息。 消息批次可能仅包含一条消息,因此在大多数情况下, 单个消息仅因批处理格式的开销而减少。然而,也有一些微妙的含义 对于消息格式转换(有关更多详细信息,请参阅下文)。另请注意 虽然以前 broker 会确保每个 fetch 请求中至少返回一条消息(无论 total 和分区级 fetch 大小),相同的行为现在适用于一个消息批次。 - GC 日志轮换默认开启,详见 KAFKA-3754。

- 已删除 RecordMetadata、MetricName 和 Cluster 类的已弃用构造函数。

- 通过新的 Headers 界面添加了用户标头支持,从而提供用户标头读取和写入访问权限。

- ProducerRecord 和 ConsumerRecord 通过

Headers headers()方法调用。 - 引入了 ExtendedSerializer 和 ExtendedDeserializer 接口以支持 Headers 的序列化和反序列化。如果配置的 serializer 和 deserializer 不是上述 class,则 Headers 将被忽略。

- 新配置

group.initial.rebalance.delay.ms。 此配置指定GroupCoordinator将延迟初始 Consumer 再平衡。 再平衡将进一步延迟group.initial.rebalance.delay.ms当新成员加入群组时,最多可添加max.poll.interval.ms. 默认值为 3 秒。 在开发和测试期间,可能需要将此设置为 0,以免延迟测试执行时间。 org.apache.kafka.common.Cluster#partitionsForTopic,partitionsForNode和availablePartitionsForTopic方法 将返回一个空列表,而不是null(这被认为是一种不好的做法),以防所需主题的元数据不存在。- Streams API 配置参数

timestamp.extractor,key.serde和value.serde已弃用,并且 替换为default.timestamp.extractor,default.key.serde和default.value.serde分别。 - 对于 Java 使用者的

commitAsyncAPI,我们不再暴露底层 cause 当RetriableCommitFailedException传递给提交回调。有关更多详细信息,请参阅 KAFKA-5052。

新协议版本

- KIP-107:FetchRequest v5 引入了分区级

log_start_offset田。 - KIP-107:FetchResponse v5 引入了分区级别

log_start_offset田。 - KIP-82:ProduceRequest v3 引入了一个

header在 Message Protocol 中,包含keyfield 和value田。 - KIP-82:FetchResponse v5 引入了一个

header在 Message Protocol 中,包含keyfield 和value田。

关于 Exactly Once 语义的说明

Kafka 0.11.0 包括对创建者中的幂等和事务功能的支持。幂等交付 确保在单个创建者的生命周期内,消息只传送到特定主题分区一次。 事务性传输允许创建者将数据发送到多个分区,以便所有消息都成功 已交付,或者都没有。这些功能共同在 Kafka 中实现了“恰好一次语义”。有关这些的更多详细信息 用户指南中提供了这些功能,但下面我们添加了一些关于在升级后的集群中启用这些功能的具体说明。 请注意,启用 EoS 不是必需的,如果未使用,则不会对代理的行为产生影响。

- 只有新的 Java 生产者和使用者支持 Exactly once 语义。

- 这些功能主要依赖于 0.11.0 消息格式。尝试使用它们 使用较旧的格式将导致不支持的版本错误。

- 交易状态存储在新的内部主题

__transaction_state.此主题在 第一次尝试使用事务请求 API。与使用者偏移量主题类似,有几个设置 以控制主题的配置。例如transaction.state.log.min.isr控制 本主题。有关选项的完整列表,请参阅用户指南中的配置部分。 - 对于安全集群,事务性 API 需要新的 ACL,可以使用

bin/kafka-acls.sh. 工具。 - Kafka 中的 EoS 引入了新的请求 API 并修改了几个现有的 API。有关详细信息,请参阅 KIP-98

关于 0.11.0 中新消息格式的说明

0.11.0 消息格式包括几项主要增强功能,以便为创建者提供更好的传递语义 (见 KIP-98) 和改进的复制容错能力 (参见 KIP-101)。 尽管新格式包含更多信息以使这些改进成为可能,但我们对批处理格式进行了大幅度的改进 更高效。只要每批的消息数大于 2,就可以降低总体开销。对于较小的 但是,可能会对性能产生较小的影响。请在此处查看我们的结果 新消息格式的初始性能分析。您还可以在 KIP-98 提案中找到有关消息格式的更多详细信息。

新消息格式的一个显著区别是,即使是未压缩的消息也作为单个批处理一起存储。

这对代理配置有一些影响max.message.bytes,这会限制单个批次的大小。第一

如果较旧的客户端使用旧格式向主题分区生成消息,并且消息单独小于max.message.bytes,在上转换过程中将它们合并为单个批次后,代理可能仍会拒绝它们。

通常,当单个消息的聚合大小大于max.message.bytes.有类似的

对从新格式向下转换的读取消息的老年使用者的影响:如果 fetch 大小未设置为至少与max.message.bytes,即使单个未压缩的消息较小,使用者也可能无法取得进展

比配置的 fetch 大小。此行为不会影响 0.10.1.0 及更高版本的 Java 客户端,因为它使用更新的 fetch 协议

这可确保至少可以返回一条消息,即使它超过了 fetch 大小。要解决这些问题,您应该确保

1) 生产者的批量大小未设置为大于max.message.bytes,以及 2) 消费者的 fetch size 设置为

最小max.message.bytes.

关于升级到 0.10.0 消息格式对性能影响的大多数讨论仍然与 0.11.0 升级相关。这主要影响自 “零拷贝” 传输以来未使用 TLS 保护的集群 在这种情况下已经不可能了。为了避免下转换的成本,您应该确保 Consumer 应用程序 已升级到最新的 0.11.0 客户端。值得注意的是,由于旧的 consumer 在 0.11.0.0 中已被弃用,因此它不支持 新的消息格式。您必须升级才能使用新使用者才能使用新的消息格式,而无需进行向下转换。 请注意,0.11.0 消费者支持向后兼容 0.10.0 代理及更高版本,因此可以升级 客户先到经纪人。

从 0.8.x、0.9.x、0.10.0.x 或 0.10.1.x 升级到 0.10.2.0

0.10.2.0 的有线协议发生了变化。通过遵循下面建议的滚动升级计划,您可以保证升级期间不会出现停机时间。 但是,请在升级之前查看 0.10.2.0 中的显著变化。

从版本 0.10.2 开始,Java 客户端(生产者和使用者)已获得与旧代理通信的能力。版本 0.10.2 客户端可以与 0.10.0 或更高版本的代理通信。但是,如果您的代理版本低于 0.10.0,则必须升级 Kafka 集群。版本 0.10.2 代理支持 0.8.x 和更新的客户端。

对于滚动升级:

- 更新所有代理上的 server.properties 文件并添加以下属性:

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.8.2、0.9.0、0.10.0 或 0.10.1)。

- log.message.format.version=CURRENT_KAFKA_VERSION (有关此配置的作用的详细信息,请参阅升级后的潜在性能影响。

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。

- 升级整个集群后,通过编辑 inter.broker.protocol.version 并将其设置为 0.10.2 来增加协议版本。

- 如果您以前的消息格式为 0.10.0,请将 log.message.format.version 更改为 0.10.2(这是一个无作,因为 0.10.0、0.10.1 和 0.10.2 的消息格式相同)。 如果您以前的消息格式版本低于 0.10.0,请不要更改 log.message.format.version - 只有在所有使用者都升级到 0.10.0.0 或更高版本后,此参数才应更改。

- 逐个重启 broker,新协议版本才能生效。

- 如果此时 log.message.format.version 仍然低于 0.10.0,请等待所有消费者都升级到 0.10.0 或更高版本, 然后将每个代理上的 log.message.format.version 更改为 0.10.2,并逐个重新启动它们。

注意:如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并启动所有代理。默认情况下,他们将从新协议开始。

注意:升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。

升级 0.10.1 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.1 升级到 0.10.2 不需要升级代理。 Kafka Streams 0.10.2 应用程序可以连接到 0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- 您需要重新编译代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 如果您使用自定义(即用户实现的)时间戳提取器,则需要更新此代码,因为

TimestampExtractor界面已更改。 - 如果您注册自定义指标,则需要更新此代码,因为

StreamsMetric界面已更改。 - 有关更多详细信息,请参阅 0.10.2 中的 Streams API 更改。

升级 0.10.0 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.0 升级到 0.10.2 确实需要升级代理,因为 Kafka Streams 0.10.2 应用程序只能连接到 0.10.2 或 0.10.1 代理。

- 有一些 API 更改,不向后兼容(有关更多详细信息,请参阅 0.10.2 中的 Streams API 更改)。 因此,您需要更新并重新编译您的代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 从 0.10.0.x 升级到 0.10.2.2 需要两次带有 config 的滚动退回

upgrade.from="0.10.0"设置为第一个升级阶段 (参见 KIP-268)。 作为替代方案,也可以进行离线升级。- 为滚动退回准备应用程序实例,并确保 config

upgrade.from设置为"0.10.0"新版本 0.10.2.2 - 退回应用程序的每个实例一次

- 为新部署的 0.10.2.2 应用程序实例准备第二轮滚动退回;确保删除 config 的值

upgrade.from - 再次退回应用程序的每个实例以完成升级

- 为滚动退回准备应用程序实例,并确保 config

- 从 0.10.0.x 升级到 0.10.2.0 或 0.10.2.1 需要离线升级(不支持滚动退回升级)

- 停止所有旧的 (0.10.0.x) 应用程序实例

- 更新您的代码,并将旧代码和 JAR 文件替换为新代码和新 JAR 文件

- 重新启动所有新的(0.10.2.0 或 0.10.2.1)应用程序实例

0.10.2.2 中的显著变化

- 新的配置参数

upgrade.from添加了允许从版本 0.10.0.x 进行滚动弹跳升级的功能

0.10.2.1 中的显著变化

- 更改了 StreamsConfig 类的两个配置的默认值,以提高 Kafka Streams 应用程序的弹性。内部 Kafka Streams 创建者

retries默认值已从 0 更改为 10。内部 Kafka Streams 使用者max.poll.interval.ms默认值已从 300000 更改为Integer.MAX_VALUE.

0.10.2.0 中的显著变化

- Java 客户端(生产者和使用者)已经获得了与旧代理通信的能力。版本 0.10.2 客户端 可以与版本 0.10.0 或更高版本的代理通信。请注意,某些功能在较旧的经纪人时不可用或受到限制 使用。

- Java 使用者上的几个方法现在可能会抛出

InterruptException如果调用线程被中断。 请参阅KafkaConsumerJavadoc 中提供了有关此更改的更深入说明。 - Java 使用者现在可以正常关闭。默认情况下,使用者最多等待 30 秒才能完成待处理请求。

已向

KafkaConsumer以控制最长等待时间。 - 可以通过 --whitelist 选项将多个以逗号分隔的正则表达式传递给具有新 Java 使用者的 MirrorMaker。这 使行为与使用旧 Scala 使用者时的 MirrorMaker 一致。

- 将 Streams 应用程序从 0.10.1 升级到 0.10.2 不需要升级代理。 Kafka Streams 0.10.2 应用程序可以连接到 0.10.2 和 0.10.1 代理(但无法连接到 0.10.0 代理)。

- Zookeeper 依赖项已从 Streams API 中删除。Streams API 现在使用 Kafka 协议来管理内部主题,而不是 直接修改 Zookeeper。这消除了直接访问 Zookeeper 和“StreamsConfig.ZOOKEEPER_CONFIG”的权限 不应再在 Streams 应用程序中设置。如果 Kafka 集群是安全的,则 Streams 应用程序必须具有创建新主题所需的安全权限。

- 添加了几个新字段,包括 “security.protocol”、“connections.max.idle.ms”、“retry.backoff.ms”、“reconnect.backoff.ms” 和 “request.timeout.ms” StreamsConfig 类。用户应注意默认值,并根据需要进行设置。更多细节请参考 3.5 Kafka Streams 配置。

新协议版本

- KIP-88:如果

topicsarray 设置为null. - KIP-88:OffsetFetchResponse v2 引入了顶级

error_code田。 - KIP-103:UpdateMetadataRequest v3 引入了

listener_namefield 添加到end_points数组。 - KIP-108:CreateTopicsRequest v1 引入了

validate_only田。 - KIP-108:CreateTopicsResponse v1 引入了

error_messagefield 添加到topic_errors数组。

从 0.8.x、0.9.x 或 0.10.0.X 升级到 0.10.1.0

0.10.1.0 有有线协议更改。通过遵循下面建议的滚动升级计划,您可以保证升级期间不会出现停机时间。 但是,请在升级前注意 0.10.1.0 中的潜在重大更改。注意:由于引入了新协议,因此在升级客户端(即 0.10.1.x 客户端)之前升级 Kafka 集群非常重要 仅支持 0.10.1.x 或更高版本的 broker,而 0.10.1.x 的 broker 也支持较旧的客户端)。

对于滚动升级:

- 更新所有代理上的 server.properties 文件并添加以下属性:

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.8.2.0、0.9.0.0 或 0.10.0.0)。

- log.message.format.version=CURRENT_KAFKA_VERSION (有关此配置的作用的详细信息,请参阅升级后的潜在性能影响。

- 一次升级一个代理:关闭代理,更新代码,然后重新启动它。

- 升级整个集群后,通过编辑 inter.broker.protocol.version 并将其设置为 0.10.1.0 来增加协议版本。

- 如果您以前的消息格式是 0.10.0,请将 log.message.format.version 更改为 0.10.1(这是一个无作,因为 0.10.0 和 0.10.1 的消息格式相同)。 如果您以前的消息格式版本低于 0.10.0,请不要更改 log.message.format.version - 只有在所有使用者都升级到 0.10.0.0 或更高版本后,此参数才应更改。

- 逐个重启 broker,新协议版本才能生效。

- 如果此时 log.message.format.version 仍然低于 0.10.0,请等待所有消费者都升级到 0.10.0 或更高版本, 然后将每个代理上的 log.message.format.version 更改为 0.10.1,并逐个重新启动它们。

注意:如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并启动所有代理。默认情况下,他们将从新协议开始。

注意:升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。

0.10.1.2 中的显著变化

- 新的配置参数

upgrade.from添加了允许从版本 0.10.0.x 进行滚动弹跳升级的功能

0.10.1.0 中的潜在重大变化

- 日志保留时间不再基于日志分段的上次修改时间。相反,它将基于日志分段中消息的最大时间戳。

- 日志滚动时间不再取决于日志分段创建时间。相反,它现在基于消息中的时间戳。更具体地说。如果分段中第一条消息的时间戳为 T,则当新消息的时间戳大于或等于 T + log.roll.ms 时,将转出日志

- 由于为每个分段添加了时间索引文件,0.10.0 的打开文件处理程序将增加 ~33%。

- time index 和 offset index 共享相同的索引大小配置。由于每个 time 索引条目的大小是偏移索引条目大小的 1.5 倍。用户可能需要增加 log.index.size.max.bytes 以避免潜在的频繁日志滚动。

- 由于索引文件数量的增加,在一些日志段量较大的 broker 上(例如 >15K),broker 启动期间的日志加载过程可能会更长。根据我们的实验,将 num.recovery.threads.per.data.dir 设置为 1 可能会减少日志加载时间。

升级 0.10.0 Kafka Streams 应用程序

- 将 Streams 应用程序从 0.10.0 升级到 0.10.1 确实需要升级代理,因为 Kafka Streams 0.10.1 应用程序只能连接到 0.10.1 代理。

- 有一些 API 更改,不向后兼容(有关更多详细信息,请参阅 0.10.1 中的 Streams API 更改)。 因此,您需要更新并重新编译您的代码。仅交换 Kafka Streams 库 jar 文件将不起作用,并且会破坏您的应用程序。

- 从 0.10.0.x 升级到 0.10.1.2 需要使用 config 进行两次滚动退回

upgrade.from="0.10.0"设置为第一个升级阶段 (参见 KIP-268)。 作为替代方案,也可以进行离线升级。- 为滚动退回准备应用程序实例,并确保 config

upgrade.from设置为"0.10.0"新版本 0.10.1.2 - 退回应用程序的每个实例一次

- 为新部署的 0.10.1.2 应用程序实例准备第二轮滚动退回;确保删除 config 的值

upgrade.from - 再次退回应用程序的每个实例以完成升级

- 为滚动退回准备应用程序实例,并确保 config

- 从 0.10.0.x 升级到 0.10.1.0 或 0.10.1.1 需要离线升级(不支持滚动退回升级)

- 停止所有旧的 (0.10.0.x) 应用程序实例

- 更新您的代码,并将旧代码和 JAR 文件替换为新代码和新 JAR 文件

- 重新启动所有新的(0.10.1.0 或 0.10.1.1)应用程序实例

0.10.1.0 中的显著变化

- 新的 Java 使用者不再处于 beta 阶段,我们建议将其用于所有新的开发。旧的 Scala 使用者仍然受支持,但它们将在下一个版本中被弃用 ,并将在未来的主要版本中删除。

- 这

--new-consumer/--new.consumerswitch 不再需要将 MirrorMaker 和 Console Consumer 等工具与新使用者一起使用;一个简单 需要传递一个 Kafka 代理来连接,而不是 ZooKeeper ensemble。此外,已弃用 Console Consumer 与旧 Consumer 的使用,它将 在将来的主要版本中删除。 - Kafka 集群现在可以通过集群 ID 进行唯一标识。当 broker 升级到 0.10.1.0 时,将自动生成它。集群 ID 可通过 kafka.server:type=KafkaServer,name=ClusterId 指标获得,它是元数据响应的一部分。序列化器、客户端拦截器和指标报告器可以通过实现 ClusterResourceListener 接口来接收集群 ID。

- 已删除 BrokerState “RunningAsController” (值 4)。由于错误,代理在转换出此状态之前只会短暂地处于此状态,因此删除的影响应该很小。检测给定代理是否为控制器的推荐方法是通过 kafka.controller:type=KafkaController,name=ActiveControllerCount 指标。

- 新的 Java Consumer 现在允许用户按时间戳搜索分区上的偏移量。

- 新的 Java Consumer 现在支持从后台线程进行检测信号。有一个新的配置

max.poll.interval.ms它控制使用者之前轮询调用之间的最长时间 将主动离开组(默认为 5 分钟)。配置的值request.timeout.ms(默认为 30 秒)必须始终小于max.poll.interval.ms(默认为 5 分钟)、 因为这是 JoinGroup 请求在使用者再平衡时可以在服务器上阻止的最长时间。 最后,默认值session.timeout.ms已下调至 10 秒,默认值max.poll.records已更改为 500。 - 当使用 Authorizer 并且用户没有对主题的 Describe 授权时,代理将不会 longer 将 TOPIC_AUTHORIZATION_FAILED 错误返回给请求,因为这会泄露主题名称。相反,UNKNOWN_TOPIC_OR_PARTITION 将返回错误代码。这可能会导致在使用 producer 和 consumer 时出现意外的超时或延迟,因为 Kafka 客户端通常会在出现未知主题错误时自动重试。如果您 怀疑这可能正在发生。

- 默认情况下,Fetch 响应具有大小限制(使用者为 50 MB,复制为 10 MB)。现有的每个分区限制也适用(使用者为 1 MB) 和复制)。请注意,这些限制都不是绝对最大值,如下一点所述。

- 如果找到大于响应/分区大小限制的消息,使用者和副本可以继续前进。更具体地说,如果 FETCH 的第一个非空 partition 大于其中一个或两个限制,则仍将返回该消息。

- 重载构造函数已添加到

kafka.api.FetchRequest和kafka.javaapi.FetchRequest以允许调用方指定 分区的顺序(因为 V3 中的顺序很重要)。以前存在的构造函数已被弃用,分区之前被随机排序 发送请求以避免匮乏问题。

新协议版本

- ListOffsetRequest v1 支持基于时间戳的精确偏移搜索。

- MetadataResponse v2 引入了一个新字段:“cluster_id”。

- FetchRequest v3 支持限制响应大小(除了现有的每个分区限制之外),它会返回消息 大于限制(如果需要)才能取得进展,并且请求中的分区顺序现在很重要。

- JoinGroup v1 引入了一个新字段:“rebalance_timeout”。

从 0.8.x 或 0.9.x 升级到 0.10.0.0

0.10.0.0 具有潜在的重大更改(请在升级前查看)以及升级后可能的性能影响。通过遵循下面建议的滚动升级计划,您可以保证在升级期间和之后不会出现停机时间,也不会对性能产生影响。

注意:由于引入了新协议,因此在升级客户端之前升级 Kafka 集群非常重要。

版本 0.9.0.0 的客户端说明: 由于 0.9.0.0 中引入的一个错误, 依赖于 ZooKeeper(旧的 Scala 高级 Consumer 和 MirrorMaker,如果与旧的 Consumer 一起使用)的客户端将不会 使用 0.10.0.x 代理。因此,在将 broker 升级到 0.9.0.1 之前,应将 0.9.0.0 客户端升级到 0.9.0.1 0.10.0.x 的对于 0.8.X 或 0.9.0.1 客户端,此步骤不是必需的。

对于滚动升级:

- 更新所有代理上的 server.properties 文件并添加以下属性:

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如 0.8.2 或 0.9.0.0)。

- log.message.format.version=CURRENT_KAFKA_VERSION (有关此配置的作用的详细信息,请参阅升级后的潜在性能影响。

- 升级代理。这可以一次完成一个 broker作,只需将其关闭、更新代码并重新启动即可。

- 升级整个集群后,通过编辑 inter.broker.protocol.version 并将其设置为 0.10.0.0 来增加协议版本。注意:您暂时不应该接触 log.message.format.version - 只有在所有消费者都升级到 0.10.0.0 后,此参数才应该更改

- 逐个重启 broker,新协议版本才能生效。

- 将所有 Consumer 升级到 0.10.0 后,将每个 Broker 的 log.message.format.version 更改为 0.10.0,然后逐个重启。

注意:如果您愿意接受停机,您可以简单地关闭所有代理,更新代码并启动所有代理。默认情况下,他们将从新协议开始。

注意:升级 broker 后,可以随时更新协议版本并重新启动。它不必紧随其后。

升级到 0.10.0.0 后的潜在性能影响